Většina týmů, které zkoumají open-source modely AI, zjistila, že LLaMA od Meta nabízí vzácnou kombinaci výkonu a flexibility, ale technické nastavení může připomínat sestavování nábytku bez návodu.

Tato příručka vás provede vytvořením funkčního chatbota LLaMA od nuly a pokryje vše od hardwarových požadavků a přístupu k modelům až po prompt engineering a strategie nasazení.

Pojďme na to!

Co je LLaMA a proč ji používat pro chatboty?

Při vytváření chatbota s proprietárními API máte často pocit, že jste uzamčeni v systému někoho jiného a čelíte nepředvídatelným nákladům a otázkám týkajícím se ochrany osobních údajů. Tato závislost na dodavateli znamená, že nemůžete model skutečně přizpůsobit jedinečným potřebám svého týmu, což vede k obecné odezvě a potenciálním problémům s dodržováním předpisů.

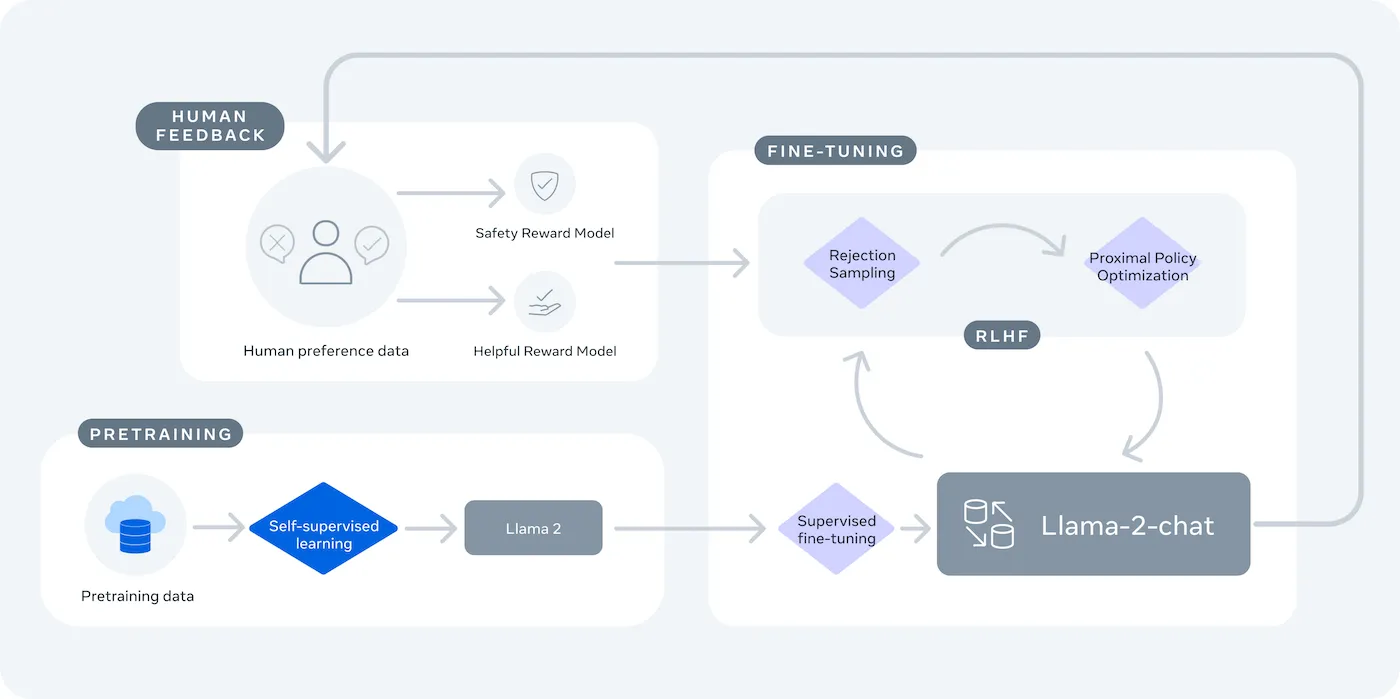

LLaMA (Large Language Model Meta AI) je řada otevřených jazykových modelů společnosti Meta, která nabízí výkonnou alternativu. Je navržena jak pro výzkumné, tak pro komerční použití a poskytuje vám kontrolu, kterou uzavřené modely nemají.

Modely LLaMA se dodávají v různých velikostech, měřených v parametrech (např. 7B, 13B, 70B). Parametry si představte jako měřítko složitosti a výkonu modelu – větší modely jsou výkonnější, ale vyžadují více výpočetních zdrojů.

Zde je několik důvodů, proč byste mohli použít chatbot LLaMA:

- Ochrana osobních údajů: Když spustíte model na vlastní infrastruktuře, vaše konverzační data nikdy neopustí vaše prostředí. To je zásadní pro týmy, které pracují s citlivými informacemi.

- Přizpůsobení: Model LLaMA můžete doladit na základě interních dokumentů nebo dat vaší společnosti. To mu pomůže porozumět vašemu konkrétnímu kontextu a poskytovat mnohem relevantnější odpovědi.

- Předvídatelnost nákladů: Po počátečním nastavení hardwaru se nemusíte starat o poplatky za API za každý token. Vaše náklady se stanou fixními a předvídatelnými.

- Žádná omezení rychlosti: Kapacita vašeho chatbota je omezena vaším vlastním hardwarem, nikoli kvótami dodavatele. Můžete jej podle potřeby škálovat.

Hlavním kompromisem je pohodlí za cenu kontroly. LLaMA vyžaduje více technického nastavení než plug-and-play API. Pro produkční chatboty týmy obvykle používají LLaMA 2 nebo novější LLaMA 3, která nabízí vylepšené uvažování a dokáže zpracovat více textu najednou.

Co potřebujete před vytvořením chatbota LLaMA

Pustit se do vývojového projektu bez správných nástrojů je recept na frustraci. Dostanete se do poloviny a zjistíte, že vám chybí klíčový kus hardwaru nebo softwaru, což zbrzdí váš pokrok a způsobí ztrátu mnoha hodin vašeho času.

Abyste tomu předešli, připravte si předem vše, co potřebujete. Zde je kontrolní seznam, který vám zajistí hladký start. 🛠️

Hardwarové požadavky

| Velikost modelu | Minimální VRAM | Alternativní možnost |

|---|---|---|

| 7 miliard parametrů | 8 GB | Cloudová instance GPU |

| 13 miliard parametrů | 16 GB | Cloudová instance GPU |

| 70 miliard parametrů | Více GPU | Kvantizace nebo cloud |

Pokud váš místní počítač nemá dostatečně výkonnou grafickou kartu (GPU), můžete využít cloudové služby jako AWS nebo GCP. Platformy pro inferenci jako Baseten a Replicate také nabízejí přístup k GPU s platbou podle skutečného využití.

Požadavky na software

- Python 3. 8+: Jedná se o standardní programovací jazyk pro projekty strojového učení.

- Správce balíčků: K instalaci knihoven potřebných pro váš projekt budete potřebovat pip nebo Conda.

- Virtuální prostředí: Jedná se o osvědčený postup, který izoluje závislosti vašeho projektu od ostatních projektů Pythonu na vašem počítači.

Požadavky na přístup

- Účet Hugging Face: K stažení váhových koeficientů modelu LLaMA budete potřebovat účet.

- Schválení Meta: Abyste získali přístup k modelům LLaMA, musíte přijmout licenční smlouvu Meta, která je obvykle schválena během několika hodin.

- API klíče: Ty jsou nutné pouze v případě, že se rozhodnete použít hostovaný inferenční koncový bod namísto lokálního spuštění modelu.

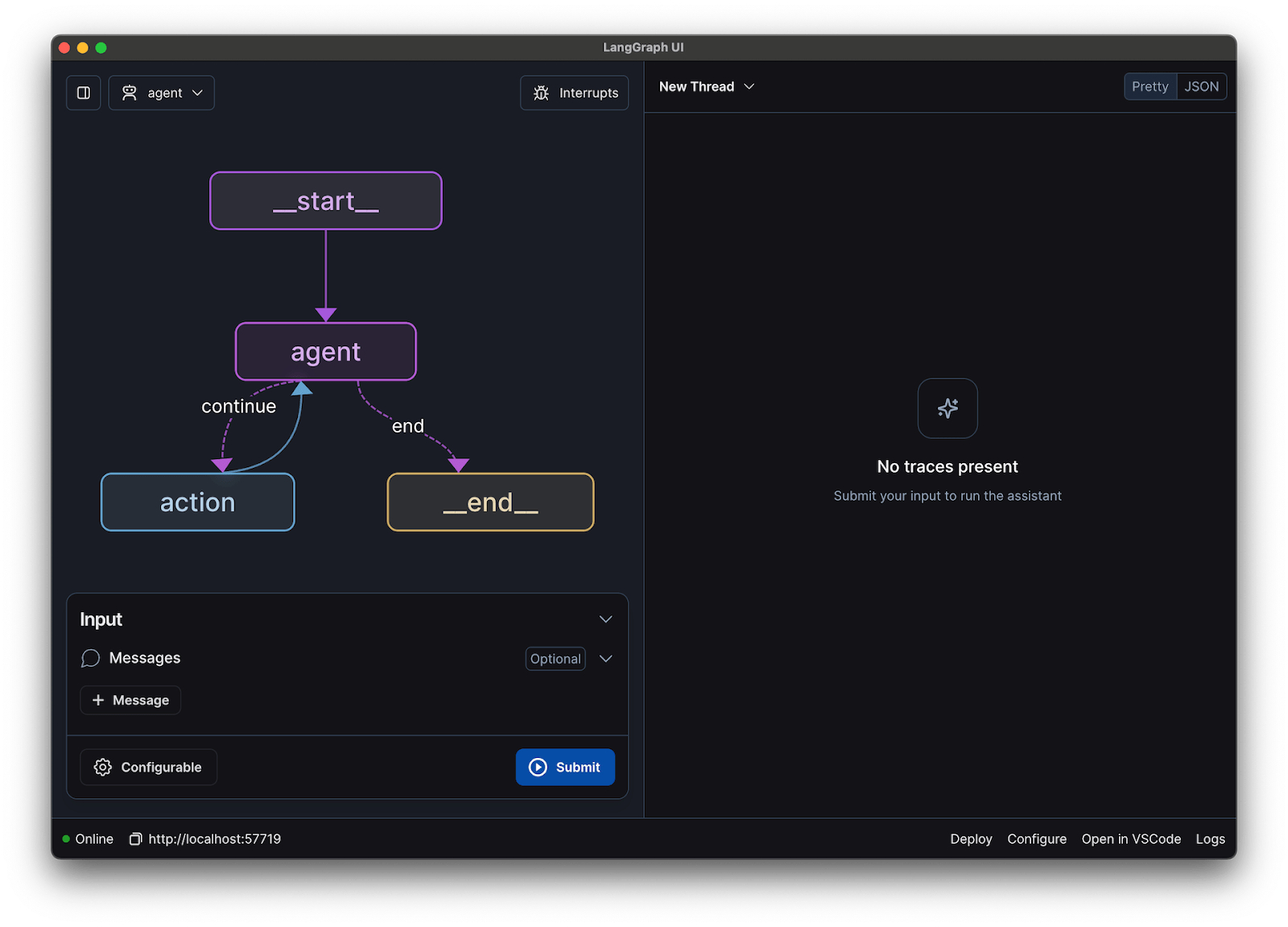

V tomto průvodci použijeme framework LangChain. Zjednodušuje mnoho složitých částí vytváření chatbota, jako je správa výzev a historie konverzací.

Jak krok za krokem vytvořit chatbot s LLaMA

Propojení všech technických částí chatbota – modelu, výzvy, paměti – může být náročné. Je snadné se ztratit v kódu, což vede k chybám a chatbotu, který nefunguje podle očekávání. Tento podrobný průvodce rozděluje proces na jednoduché, zvládnutelné části.

Tento přístup funguje bez ohledu na to, zda model provozujete na svém vlastním počítači nebo používáte hostovanou službu.

Krok 1: Nainstalujte požadované balíčky

Nejprve je třeba nainstalovat základní knihovny Pythonu. Otevřete terminál a spusťte tento příkaz:

pip install langchain transformers accelerate torch

Pokud pro inferenci používáte hostovanou službu, jako je Baseten, budete muset nainstalovat také její specifickou sadu pro vývoj softwaru (SDK):

pip install baseten

Zde je přehled funkcí jednotlivých balíčků:

- Langchain: Framework, který pomáhá vytvářet aplikace s velkými jazykovými modely, včetně správy konverzačních řetězců a paměti.

- Transformátory: Knihovna Hugging Face pro načítání a spouštění modelu LLaMA.

- Accelerate: Knihovna, která pomáhá optimalizovat načítání modelu do CPU a GPU.

- Torch: Knihovna PyTorch, která poskytuje backendový výkon pro výpočty modelu.

Pokud model provozujete lokálně na počítači s grafickou kartou NVIDIA, ujistěte se, že máte nainstalován a správně nakonfigurován CUDA. To umožní modelu využívat grafickou kartu pro mnohem rychlejší výkon.

Krok 2: Získejte přístup k modelům LLaMA

Než si budete moci model stáhnout, musíte získat oficiální přístup od Meta prostřednictvím Hugging Face.

- Vytvořte si účet na huggingface.co

- Přejděte na stránku modelu, například meta-llama/Llama-2-7b-chat-hf.

- Klikněte na „Přístup k úložišti“ a souhlaste s licenčními podmínkami společnosti Meta.

- V nastavení účtu Hugging Face vygenerujte nový přístupový token.

- V terminálu spusťte příkaz huggingface-cli login a vložte svůj token pro ověření svého zařízení.

Schválení je obvykle rychlé. Ujistěte se, že jste vybrali variantu modelu s názvem „chat“, protože tyto modely byly speciálně vycvičeny pro konverzační úkoly.

Krok 3: Načtěte model LLaMA

Nyní můžete model načíst do svého kódu. V závislosti na vašem hardwaru máte dvě hlavní možnosti.

Pokud máte dostatečně výkonnou grafickou kartu, můžete model načíst lokálně:

Pokud máte omezený hardware, můžete použít hostovanou inferenční službu:

Příkaz device_map="auto" řekne knihovně transformers, aby automaticky distribuovala model na všechny dostupné GPU.

Pokud vám stále dochází paměť, můžete použít techniku zvanou kvantizace, která zmenší velikost modelu, i když to může mírně snížit jeho výkon.

Krok 4: Vytvořte šablonu výzvy

Chatovací modely LLaMA jsou trénovány tak, aby očekávaly konkrétní formát podnětů. Šablona podnětu zajišťuje správnou strukturu vašeho vstupu.

Rozebrat tento formát:

- <

>: Tato část obsahuje systémovou výzvu, která modelu poskytuje základní pokyny a definuje jeho osobnost. - [INST]: Označuje začátek otázky nebo pokynu uživatele.

- [/INST]: Tím se modelu signalizuje, že je čas vygenerovat odpověď.

Mějte na paměti, že různé verze LLaMA mohou používat mírně odlišné šablony. Vždy zkontrolujte dokumentaci modelu na Hugging Face, abyste se ujistili, že formát je správný.

Krok 5: Nastavte řetězec chatbotů

Dále propojíte svůj model a šablonu výzvy do konverzačního řetězce pomocí LangChain. Tento řetězec bude také obsahovat paměť pro sledování konverzace.

LangChain nabízí několik typů paměti:

- ConversationBufferMemory: Jedná se o nejjednodušší možnost. Ukládá celou historii konverzace.

- ConversationSummaryMemory: Aby se ušetřilo místo, tato možnost pravidelně shrnuje starší části konverzace.

- ConversationBufferWindowMemory: Uchovává v paměti pouze několik posledních výměn, což je užitečné pro zabránění přílišnému prodloužení kontextu.

Pro testování je ConversationBufferMemory skvělým místem, kde začít.

Krok 6: Spusťte smyčku chatbota

Nakonec můžete vytvořit jednoduchou smyčku pro interakci s chatbotem z terminálu.

V reálné aplikaci byste tuto smyčku nahradili koncovým bodem API pomocí frameworku jako FastAPI nebo Flask. Můžete také streamovat odpověď modelu zpět uživateli, díky čemuž bude chatbot působit mnohem rychleji.

Můžete také upravit parametry, jako je teplota, abyste mohli ovládat náhodnost odpovědí. Nízká teplota (např. 0,2) činí výstup determinističtější a faktografičtější, zatímco vyšší teplota (např. 0,8) podporuje větší kreativitu.

📚 Přečtěte si také: AI agent vs. chatbot: klíčové rozdíly a který z nich je pro vás ten pravý?

Jak otestovat chatbota LLaMA

Vytvořili jste chatbota, který poskytuje odpovědi, ale je připraven pro skutečné uživatele? Nasazení nevyzkoušeného bota může vést k trapným selháním, jako je poskytování nesprávných informací nebo generování nevhodného obsahu, což může poškodit pověst vaší společnosti.

Řešením této nejistoty je systematický testovací plán. Ten zajistí, že váš chatbot bude robustní, spolehlivý a bezpečný.

Funkční testování:

- Okrajové případy: Otestujte, jak bot zpracovává prázdné vstupy, velmi dlouhé zprávy a speciální znaky.

- Ověření paměti: Zajistěte, aby si chatbot pamatoval kontext napříč několika tahy v konverzaci.

- Postupujte podle pokynů: Zkontrolujte, zda bot dodržuje pravidla, která jste nastavili v systémové výzvě.

Hodnocení kvality:

- Relevance: Odpovídá odpověď skutečně na otázku uživatele?

- Přesnost: Jsou informace, které poskytuje, správné?

- Soudržnost: Je konverzace logická?

- Bezpečnost: Odmítá bot odpovídat na nevhodné nebo škodlivé požadavky?

Testování výkonu:

- Latence: Změřte, jak dlouho trvá, než bot začne odpovídat a dokončí svou odpověď.

- Využití zdrojů: Sledujte, kolik paměti GPU model používá během inferenčního procesu.

- Souběžnost: Otestujte, jak systém funguje, když s ním současně interaguje více uživatelů.

Dávejte také pozor na běžné problémy LLM, jako jsou halucinace (sebevědomé uvádění nepravdivých informací), posun kontextu (ztráta přehledu o tématu v dlouhé konverzaci) a opakování. Zaznamenávání všech testovacích konverzací je skvělý způsob, jak odhalit vzorce a opravit problémy, než se dostanou k vašim uživatelům.

📚 Přečtěte si také: Rozdíl mezi funkčním testováním a nefunkčním testováním

Případy použití chatbotu LLaMA pro týmy

Jakmile překonáte mechaniku jemného doladění a nasazení, LLaMA se stane nejcennější při aplikaci na každodenní problémy týmu – nikoli na abstraktní ukázky AI. Týmy obvykle nepotřebují „chatbota“, ale rychlejší přístup k informacím, méně manuálních předávek a méně opakující se práce.

Interní znalostní asistent

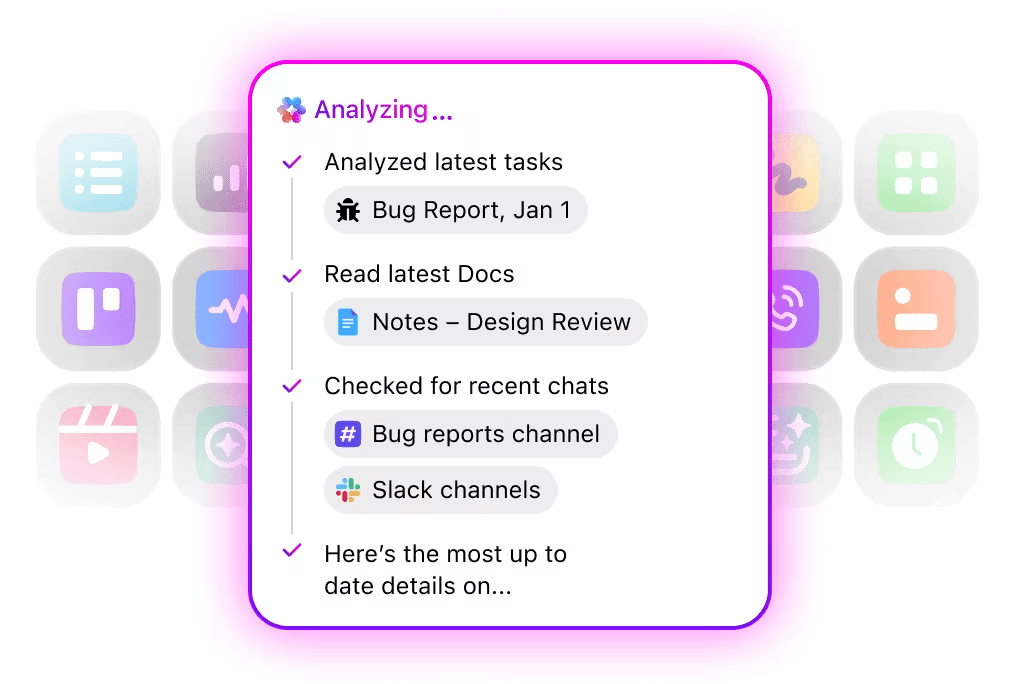

Díky doladění LLaMA na základě interní dokumentace, wiki a často kladených otázek – nebo jejím spojením s znalostní bází založenou na RAG – mohou týmy klást otázky v přirozeném jazyce a získávat přesné odpovědi s ohledem na kontext. Odstraňuje se tak nutnost prohledávat roztříštěné nástroje a citlivá data zůstávají plně interní, namísto jejich odesílání do API třetích stran.

🌟 Enterprise Search v ClickUp a předem připravený agent Ambient Answers poskytují podrobné kontextové odpovědi na vaše otázky s využitím znalostí ve vašem pracovním prostoru ClickUp.

Pomocník pro kontrolu kódu

Po proškolení na základě vaší vlastní kódové základny a stylových příruček může LLaMA fungovat jako kontextový asistent pro kontrolu kódu. Namísto obecných osvědčených postupů získávají vývojáři návrhy, které jsou v souladu s konvencemi týmu, architektonickými rozhodnutími a historickými vzory.

🌟 Pomocník pro kontrolu kódu založený na LLaMA může odhalit problémy, navrhnout vylepšení nebo vysvětlit neznámý kód. Codegen od ClickUp jde ještě o krok dál a působí přímo ve vývojovém workflow – vytváří pull requesty, aplikuje refaktory nebo aktualizuje soubory přímo na základě těchto poznatků. Výsledkem je méně kopírování a vkládání a méně přerušení mezi „myšlením“ a „konáním“.

Třídění zákaznické podpory

LLaMA lze vycvičit pro klasifikaci záměrů, aby rozuměl příchozím dotazům zákazníků a směroval je ke správnému týmu nebo workflow. Běžné dotazy lze zpracovat automaticky, zatímco okrajové případy jsou eskalovány k lidským agentům s přiloženým kontextem, což zkracuje dobu odezvy bez snížení kvality.

Můžete také vytvořit Triage Super Agent pomocí přirozeného jazyka ve svém pracovním prostoru ClickUp. Další informace

Shrnutí schůzek a následné kroky

Na základě přepisů schůzek dokáže LLaMA extrahovat rozhodnutí, akční položky a klíčové body diskuse. Skutečná hodnota se projeví, když se tyto výstupy přímo přenesou do nástrojů pro správu úkolů, čímž se konverzace promění v sledovanou práci.

🌟 AI Meeting Notetaker od ClickUp nejenže pořizuje poznámky z jednání, ale také vytváří souhrny, generuje úkoly a propojuje poznámky z jednání s vašimi dokumenty a úkoly.

Vypracování a iterace dokumentů

Týmy mohou pomocí LLaMA generovat první návrhy zpráv, návrhů nebo dokumentace na základě existujících šablon a minulých příkladů. Tím se úsilí přesouvá od vytváření prázdných stránek k revizi a vylepšování, což urychluje dodání bez snížení standardů.

🌟 ClickUp Brain dokáže rychle generovat návrhy dokumentace a uchovává všechny vaše pracovní znalosti v kontextu. Vyzkoušejte ho ještě dnes.

Chatboty založené na LLaMA jsou nejúčinnější, když jsou začleněny do stávajících pracovních postupů – dokumentace, řízení projektů a týmové komunikace – spíše než když fungují jako samostatné nástroje.

Právě zde integrace AI přímo do vašeho pracovního prostoru přináší zásadní rozdíl. Místo vytváření samostatného nástroje můžete konverzační AI přenést tam, kde váš tým již pracuje.

Můžete například vytvořit vlastní bot LLaMA, který bude fungovat jako znalostní asistent. Pokud však bude mimo váš nástroj pro správu projektů, váš tým bude muset přepínat kontexty, aby mu mohl položit otázku. To vytváří tření a zpomaluje práci všech.

Eliminujte tuto změnu kontextu pomocí AI, která je již součástí vašeho pracovního postupu.

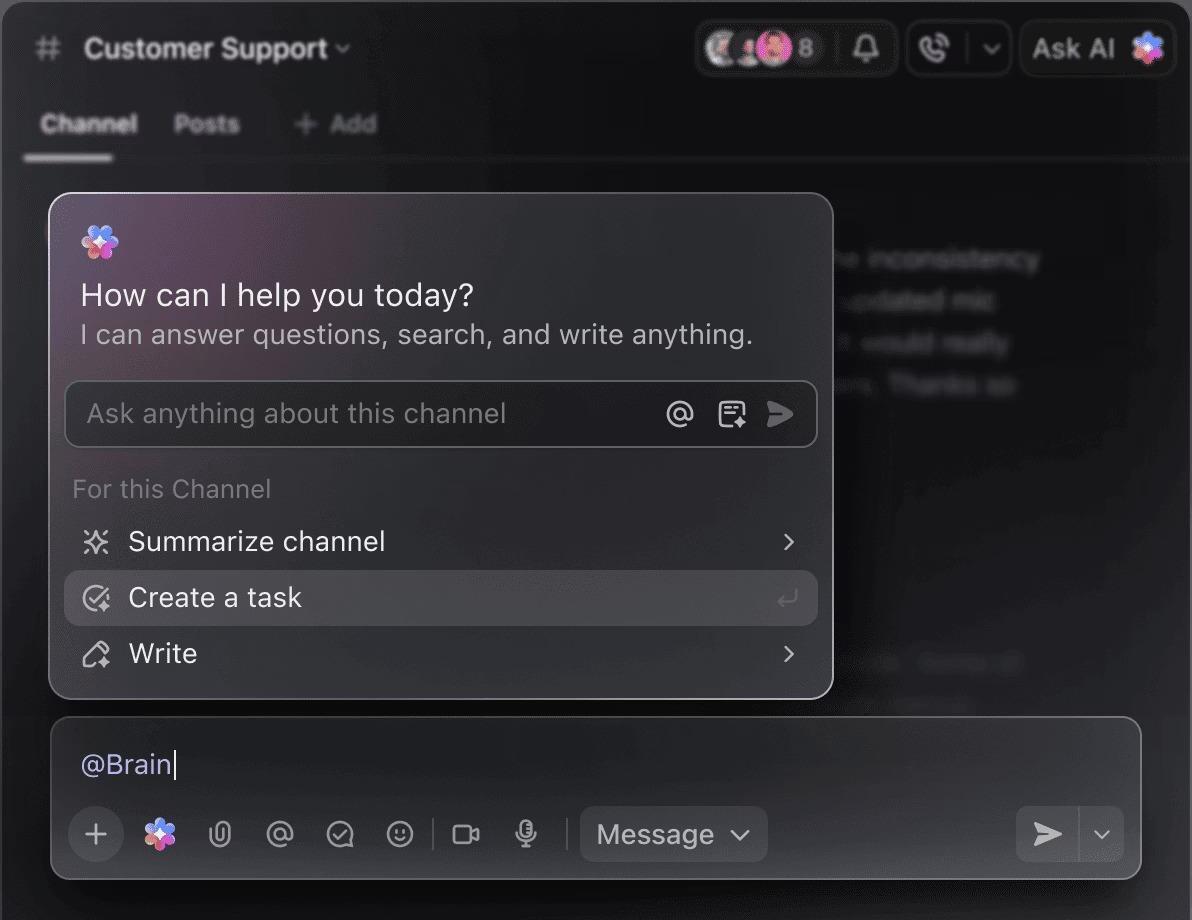

Ptejte se na své projekty, úkoly a dokumenty, aniž byste museli opustit ClickUp, pomocí ClickUp Brain. Stačí napsat @brain do libovolného komentáře k úkolu nebo do ClickUp Chatu a získáte okamžitou odpověď s ohledem na kontext. Je to jako mít člena týmu, který dokonale zná celý váš pracovní prostor. 🤩

Díky tomu se chatbot změní z novinky na klíčovou součást motoru produktivity vašeho týmu.

Omezení používání LLaMA pro vytváření chatbotů

Vytvoření chatbota LLaMA může být inspirující, ale týmy jsou často zaskočeny skrytými složitostmi. „Bezplatný“ model s otevřeným zdrojovým kódem může být nakonec dražší a obtížněji spravovatelný, než se očekávalo, což vede ke špatné uživatelské zkušenosti a neustálému cyklu údržby, který vyčerpává zdroje.

Než se rozhodnete, je důležité pochopit omezení.

- Technická náročnost: Nastavení a údržba modelu LLaMA vyžaduje znalosti infrastruktury strojového učení.

- Hardwarové požadavky: Provozování větších a výkonnějších modelů vyžaduje drahý GPU hardware a náklady na cloud se mohou rychle nasčítat.

- Omezení kontextového okna: Modely LLaMA mají omezenou paměť ( 4K tokenů pro LLaMA 2 ). Zpracování dlouhých dokumentů nebo konverzací vyžaduje komplexní strategie rozdělování na části.

- Žádná vestavěná bezpečnostní opatření: Jste zodpovědní za implementaci vlastních opatření pro filtrování obsahu a bezpečnost.

- Průběžná údržba: Jakmile budou vydány nové modely, budete muset aktualizovat své systémy a vyladěné modely mohou vyžadovat nové školení.

Samostatně hostované modely mají také obvykle vyšší latenci než vysoce optimalizované komerční API. To vše jsou provozní zátěže, které za vás vyřeší spravovaná řešení.

📮ClickUp Insight: 88 % respondentů našeho průzkumu používá AI pro své osobní úkoly, ale více než 50 % se bojí ji používat v práci. Jaké jsou tři hlavní překážky? Nedostatečná integrace, nedostatek znalostí nebo obavy o bezpečnost.

Ale co když je AI zabudována do vašeho pracovního prostoru a je již bezpečná? ClickUp Brain, vestavěný AI asistent ClickUp, to činí realitou. Rozumí pokynům v běžném jazyce, řeší všechny tři obavy spojené s přijetím AI a zároveň propojuje váš chat, úkoly, dokumenty a znalosti v celém pracovním prostoru. Najděte odpovědi a poznatky jediným kliknutím!

Alternativy k LLaMA pro vytváření chatbotů

LLaMA je jen jednou z mnoha možností v moři modelů AI a může být obtížné zjistit, který z nich je pro vás ten pravý.

Zde je přehled dostupných alternativ.

Další open-source modely:

- Mistral: Známý pro svůj vysoký výkon i u menších modelů, díky čemuž je velmi efektivní.

- Falcon: Dodává se s velmi liberální licencí, která je ideální pro komerční aplikace.

- MPT: Optimalizováno pro zpracování dlouhých dokumentů a konverzací.

Komerční API:

- OpenAI (GPT-4, GPT-3. 5): Obecně považovány za nejschopnější velké jazykové modely, které se velmi snadno integrují.

- Anthropic (Claude): Známý díky silným bezpečnostním funkcím a velmi velkým kontextovým oknům.

- Google (Gemini): Nabízí výkonné multimodální funkce, které mu umožňují rozumět textu, obrázkům a zvuku.

Můžete si jej vytvořit sami pomocí open-source modelu, zaplatit za komerční API nebo použít konvergované AI pracovní prostředí, které nabízí předem integrované řešení s různými typy AI agentů.

📚 Přečtěte si také: Jak využít chatbota pro vaše podnikání

Vytvořte kontextově orientované AI asistenty s ClickUp

Vytvoření chatbota pomocí LLaMA vám poskytuje neuvěřitelnou kontrolu nad vašimi daty, náklady a přizpůsobením. Tato kontrola však s sebou nese odpovědnost za infrastrukturu, údržbu a bezpečnost – vše, co za vás vyřeší spravované API. Cílem není jen vytvořit bota, ale také zvýšit produktivitu vašeho týmu, a složitý technický projekt vás od toho může někdy odvést.

Správná volba závisí na zdrojích a prioritách vašeho týmu. Pokud máte odborné znalosti v oblasti strojového učení a přísné požadavky na ochranu soukromí, je LLaMA fantastickou volbou. Pokud upřednostňujete rychlost a jednoduchost, může být vhodnější integrovaný nástroj.

S ClickUp získáte konvergované AI pracovní prostředí, kde jsou všechny vaše úkoly, dokumenty a konverzace na jednom místě, poháněné integrovanou AI. Omezuje rozptýlení kontextu a pomáhá týmům pracovat rychleji a efektivněji, s těmi správnými informacemi na dosah ruky díky přizpůsobitelným Super Agentům a kontextové AI.

Přestaňte ztrácet čas infrastrukturou a využijte výhody kontextově orientovaného AI asistenta ještě dnes, aniž byste museli cokoli budovat od základů. Začněte zdarma s ClickUp.

Často kladené otázky (FAQ)

Náklady závisí zcela na způsobu nasazení a jejich odhad vám pomůže projektová prognóza. Pokud používáte vlastní hardware, budete mít počáteční náklady na GPU, ale žádné průběžné poplatky za dotazy. Poskytovatelé cloudových služeb účtují hodinovou sazbu na základě GPU a velikosti modelu.

Ano, licence pro LLaMA 2 a LLaMA 3 umožňují komerční použití. Musíte však souhlasit s podmínkami použití společnosti Meta a ve svém produktu uvést požadované údaje o autorství.

LLaMA 3 je novější a výkonnější model, který nabízí lepší schopnosti uvažování a větší kontextové okno (8K tokenů oproti 4K u LLaMA 2). To znamená, že zvládá delší konverzace a dokumenty, ale také vyžaduje více výpočetních zdrojů.

Ačkoli je Python díky svým rozsáhlým knihovnám nejběžnějším jazykem pro strojové učení, není to striktně nutné. Některé platformy začínají nabízet řešení bez kódu nebo s minimem kódu, která vám umožňují nasadit chatbot LLaMA s grafickým rozhraním. /