De flesta team testar LLM-sammanfattningsverktyg genom att mata in ett exempeldokument och sedan anse att testet är klart. Den modell som klarar dina kvartalsrapporter med bravur kan förstöra dina Slack-trådar, och den som är perfekt för juridiska sammanfattningar kan förvränga fakta i dina kundmejl.

Denna guide går igenom de bästa LLM:erna för textsammanfattning, hur du utvärderar dem mot din faktiska arbetsbelastning och hur du kopplar samman dessa sammanfattningar direkt till åtgärder i ditt arbetsflöde.

LLM-sammanfattningsmodeller i korthet

| Modell | Bäst för | Bästa funktioner | Prissättning |

|---|---|---|---|

| ClickUp Brain | Team som vill ha sammanfattningar direkt i sitt arbetsflöde Teamstorlek: Alla team som använder ClickUp för projekt och kommunikation | Arbetsplatsanpassade sammanfattningar, mötesreferat med AI Notetaker, skapande av åtgärdspunkter, multi-LLM-routing, sökning med naturligt språk | Helt gratis; anpassningsbar för företag. |

| OpenAI GPT-4o | Polerade sammanfattningar som är redo att presenteras för ledningen Teamstorlek: Små till stora team som behöver högkvalitativa abstrakta resultat | Mänskliga sammanfattningar, multimodalt stöd, stark instruktionsföljsamhet, stort kontextfönster | API-betalning per token, ChatGPT Plus 20 $/månad |

| Claude 3. 5 Sonnet | Kravkänsliga eller mycket tekniska dokumentTeamstorlek: Juridiska, finansiella och företagsrelaterade team | Utökat kontextfönster, låg hallucination, utmärkt formatkontroll, starkt resonemang | API-betalning per token, Claude Pro-prenumeration |

| Google Gemini 1. 5 Pro | Team som arbetar intensivt i Google WorkspaceTeamstorlek: Drift, forskning, team med många möten | Upp till 1 miljon token i kontextfönstret, integration med Google Meet och Drive, multimodal sammanfattning | Användningsbaserad prissättning via Google AI Studio eller Vertex AI |

| Meta LLaMA 3 | Självhostade och anpassningsbara sammanfattningspipelines Teamstorlek: Teknikledda, integritetsfokuserade team | Helt självhostad, finjusteringsfunktion, hög sammanfattningskvalitet, fullständig datakontroll | Gratis öppen källkodsviktning, infrastrukturkostnader tillkommer. |

| Mistral Large | Team som behöver EU-dataresidens och hybriddistribution Teamstorlek: EU-företag eller compliance-drivna organisationer | Hybridhanterad API eller självhostad, hög sammanfattningskvalitet, effektiv tokenanvändning | Konkurrenskraftiga API-priser, öppna vikter tillgängliga |

Hur vi granskar programvara på ClickUp

Vår redaktion följer en transparent, forskningsbaserad och leverantörsneutral process, så du kan lita på att våra rekommendationer baseras på produkternas verkliga värde.

Här är en detaljerad översikt över hur vi granskar programvara på ClickUp.

Vad ska du leta efter i en LLM för sammanfattning?

Att välja fel sammanfattningsmodell leder till slöseri med pengar på klumpiga API:er, problem med komplexa inställningar eller helt enkelt sammanfattningar av låg kvalitet som inte är till någon hjälp. Innan du dyker in i specifika modeller är det bra att förstå vad som skiljer effektiv sammanfattning från generisk output, så att du kan göra ett smartare val.

Hantera dina faktiska dokumenttyper

En modell som är utmärkt för att sammanfatta forskningsrapporter kan ha svårt med konversationer i Slack-trådar eller mötesprotokoll. Leta efter LLM:er som har testats på de specifika dokumenttyper som ditt team arbetar med dagligen – oavsett om det är juridiska avtal, kundmejl, teknisk dokumentation eller mötesanteckningar.

Erbjuder tillräckligt kontextfönster

Kontextfönstret avgör hur mycket text modellen kan bearbeta i ett enda steg. Om du sammanfattar timslånga mötesprotokoll eller långa forskningsrapporter behöver du en modell med ett utökat kontextfönster. Annars måste du dela upp dokumenten i mindre delar och förlorar den sammanhang som uppstår när allt bearbetas tillsammans.

Balanserar hastighet och kvalitet

Vissa modeller prioriterar inferenshastighet medan andra optimeras för utskriftskvalitet. För sammanfattning i realtid under möten är hastigheten viktigare. För att generera sammanfattningar för ledningen är kvaliteten viktigast. Fundera över var dina användningsfall hamnar i detta spektrum.

Ger lämpliga åtkomstalternativ

Ditt teams tekniska resurser och säkerhetskrav bör avgöra om du behöver en hanterad API, egenhostad distribution eller en hybridlösning. Företagsteam med strikta datapolicyer kan behöva lokala alternativ, medan mindre team kanske föredrar bekvämligheten med moln-API:er.

De 6 bästa LLM:erna för textsammanfattning

Det överväldigande antalet tillgängliga modeller gör det svårt att välja rätt. Varje modell nedan är en stark kandidat, men vilken som är "bäst" beror helt på ditt teams specifika behov. Vi utvärderar dem utifrån noggrannhet, kontextfönstrets storlek, hastighet och åtkomstalternativ.

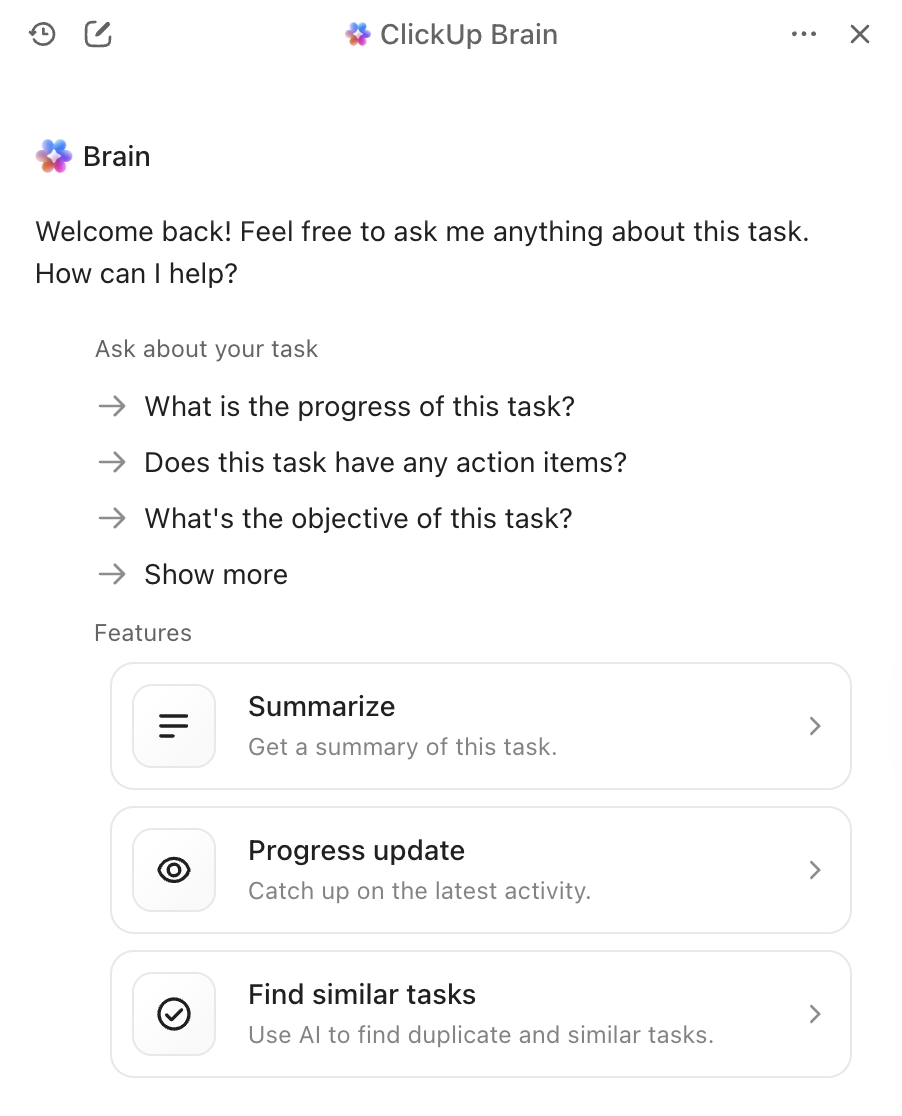

1. ClickUp Brain (bäst för AI-driven sammanfattning inom ditt arbetsflöde)

Det största problemet med fristående sammanfattningsverktyg är inte kvaliteten på sammanfattningarna – det är vad som händer efteråt. Du skapar en briljant sammanfattning, kopierar den manuellt till ditt projektledningsverktyg, skapar uppgifter utifrån den och meddelar ditt team om nästa steg. ClickUp Brain eliminerar denna friktion genom att integrera sammanfattningen direkt i ditt arbetsflöde.

Med ClickUp Brain skriver du bara @brain i en uppgiftskommentar eller ett ClickUp Chat-meddelande och ber det att sammanfatta sammanhanget. Det ger omedelbart en sammanfattning med hjälp av sin kunskap om din arbetsyta och prioriterar den specifika uppgiften eller kanalen du befinner dig i. Eftersom Brain förstår dina projekt, dokument och konversationer är dess sammanfattningar omedelbart användbara istället för isolerad text som du måste bearbeta manuellt.

ClickUp Brains bästa funktioner

- Sammanfattar uppgifter, dokument, chattråd och mötesinspelningar utan att du behöver lämna din arbetsplats.

- Utnyttjar flera LLM bakom kulisserna så att du får optimala resultat utan att behöva hantera modellvalet.

- Omvandlar sammanfattningar direkt till uppgifter med ansvariga och förfallodatum.

- Förstår sammanhanget i din arbetsmiljö för mer relevanta och användbara sammanfattningar.

- Integreras med ClickUp AI Notetaker för att automatiskt registrera och sammanfatta möten.

Begränsningar för ClickUp Brain

- Kräver arbete inom ClickUp-ekosystemet för att få full nytta av fördelarna.

- Passar bäst för teamarbetsflöden snarare än individuell dokumenthantering.

Priser för ClickUp Brain

2. OpenAI GPT-4o (Bäst för polerade sammanfattningar som är redo att presenteras för ledningen)

När du behöver en sammanfattning som är polerad, nyanserad och redo att delas med ledningen är GPT-4o ett förstklassigt val. Dess styrka ligger i högkvalitativ abstrakt sammanfattning, som producerar text som låter som om den skrivits av en människa. Det stora kontextfönstret och multimodala funktionerna innebär att den kan sammanfatta text från bilder eller ljudtranskriptioner, inte bara dokument.

Du kan komma åt det via ett allmänt tillgängligt API, vilket gör det enkelt att integrera i dina befintliga AI-verktyg för möten. Nackdelen är att det är en proprietär tjänst med användningsbaserad prissättning, och du kan märka en viss fördröjning när du sammanfattar mycket långa dokument.

GPT-4o:s bästa funktioner

- Producerar sammanfattningar av mänsklig kvalitet som kräver minimal redigering.

- Hanterar multimodala indata, inklusive bilder och ljudtranskriptioner.

- Erbjuder omfattande API-dokumentation och integrationsstöd.

Begränsningar för GPT-4o

- Användningsbaserad prissättning kan bli dyr vid sammanfattning av stora volymer.

- Inferenslatensen ökar med mycket långa dokument.

- Egenutvecklad modell innebär mindre kontroll över datahanteringen

Priser för GPT-4o

- API-åtkomst med prissättning per token

- ChatGPT Plus-abonnemang för 20 USD/månad för privat bruk

3. Anthropic Claude 3. 5 Sonnet (bäst för dokument som kräver efterlevnad av regler)

Om ditt team hanterar mycket känsliga eller komplexa dokument är Claude 3. 5 Sonnet utformat med dina behov i åtanke. Det har ett utökat kontextfönster, vilket gör att det kan bearbeta och sammanfatta hela långa rapporter i ett enda steg. Det som verkligen utmärker det är dess förmåga att följa nyanserade instruktioner – du kan be om en sammanfattning i ett specifikt format, med en viss ton eller med fokus på vissa ämnen, och det levererar med hög noggrannhet.

Anthropics starka fokus på säkerhetsanpassning bidrar till att minska risken för att modellen hittar på fakta, vilket är en viktig funktion för compliance-medvetna team som arbetar med juridiska eller finansiella dokument. För team som redan använder AI-dokument sammanfattare integreras Claude väl i befintliga arbetsflöden.

Claude 3. 5 Sonnet bästa funktioner

- Utökat kontextfönster bearbetar hela rapporter i ett enda steg

- Utmärkt förmåga att följa instruktioner för anpassade formaterings- och tonkrav

- Stark säkerhetsanpassning minskar risken för hallucinationer

Claude 3. 5 Sonnet-begränsningar

- Egenutvecklad modell med regionala variationer i tillgänglighet

- API-prissättningen kan vara betydande för användning i företagsstorlek.

Claude 3. 5 Sonnet-prissättning

- API-åtkomst med prissättning per token

- Claude Pro-prenumeration tillgänglig för individuellt bruk

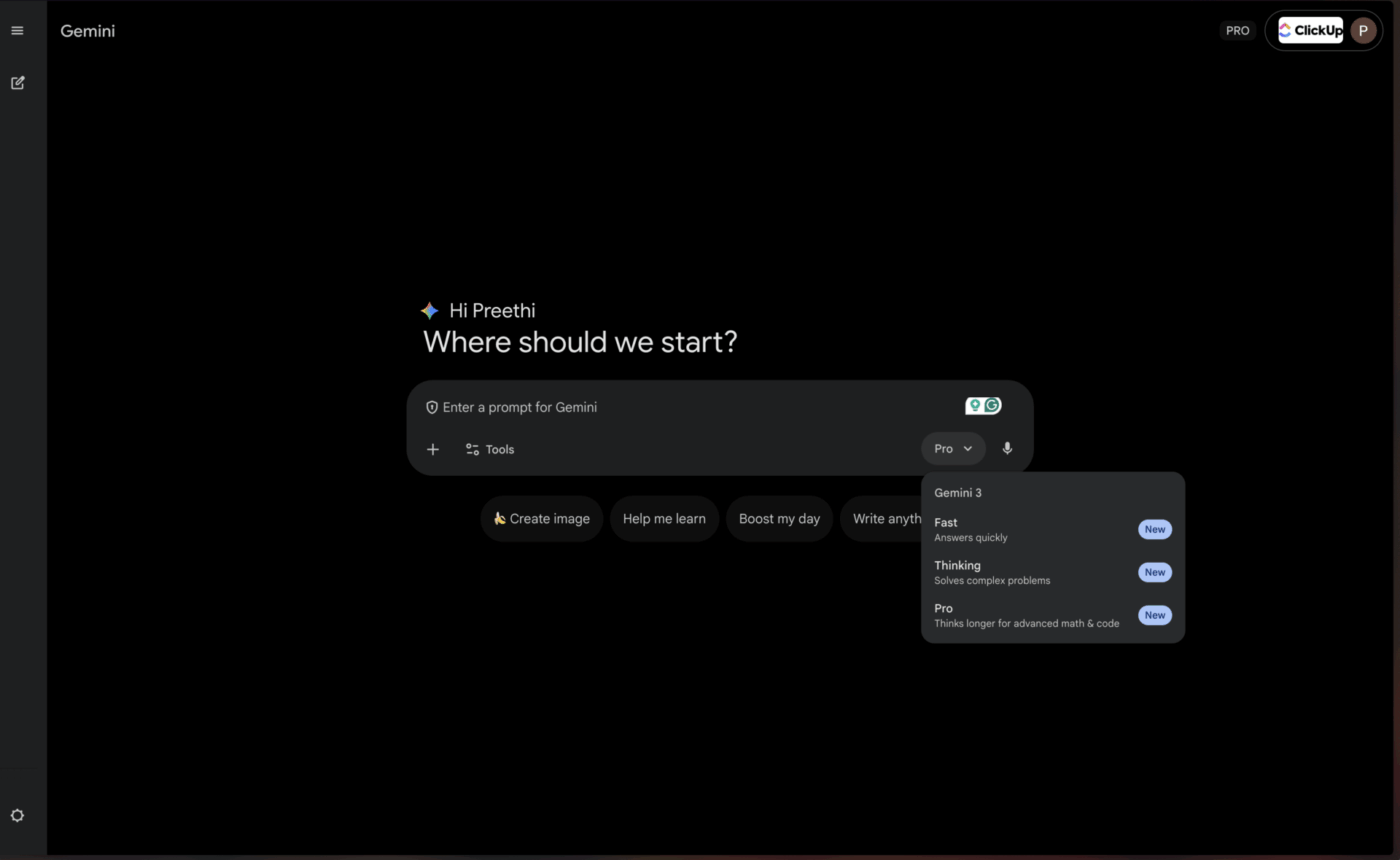

4. Google Gemini 1. 5 Pro (bäst för användare av Google Workspace)

För team som redan lever och andas i Googles ekosystem erbjuder Gemini 1. 5 Pro en nästan oslagbar bekvämlighet. Den har ett av de största kontextfönstren som finns tillgängliga idag – upp till 1 miljon token – vilket gör den perfekt för att sammanfatta omfattande mötesprotokoll från Google Meet eller syntetisera information från flera forskningsrapporter som lagras i Google Drive.

Den inbyggda integrationen med Google Workspace innebär att du kan få sammanfattningar utan att behöva lämna de verktyg du använder varje dag. Detta gör det särskilt värdefullt för team som är starkt beroende av AI-mötesreferenter inom Googles ekosystem.

Gemini 1. 5 Pro bästa funktioner

- Ett enormt kontextfönster med 1 miljon token hanterar extremt långa dokument.

- Inbyggd integration med Google Workspace för ett smidigt arbetsflöde

- Multimodala funktioner för text, bilder och video

Begränsningar för Gemini 1. 5 Pro

- För att dra full nytta av fördelarna krävs investeringar i Googles ekosystem.

- Prestanda utanför Google-integrationen kan ligga efter konkurrenterna.

Priser för Gemini 1. 5 Pro

- Tillgängligt via Google AI Studio och Vertex AI.

- Priserna varierar beroende på användning och företagsavtal.

📌 ClickUp Insight: Den genomsnittliga yrkesverksamma person spenderar mer än 30 minuter om dagen på att söka efter arbetsrelaterad information – det är över 120 timmar om året som går förlorade på att leta igenom e-postmeddelanden, Slack-trådar och spridda filer. En intelligent AI-assistent inbyggd i din arbetsyta kan ändra på det genom att visa rätt dokument, konversationer och uppgiftsdetaljer på några sekunder.

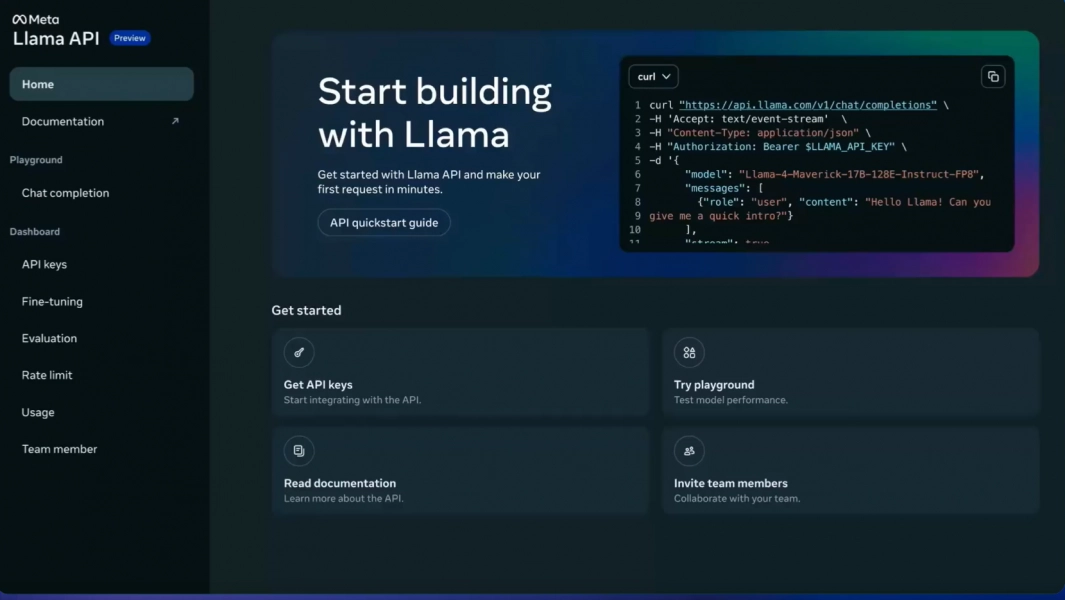

5. Meta LLaMA 3 (Bäst för självhostade, anpassningsbara pipelines)

Ditt team behöver full kontroll över sina data och vill undvika att skicka känslig information till en tredjepartstjänst. Det är här en öppen källkodsmodell som LLaMA 3 kommer till sin rätt. Du kan hosta den på dina egna servrar, finjustera den efter ditt företags specifika data för att bättre förstå din jargong och anpassa den på det sätt du finner lämpligt – allt utan licensavgifter.

Sammanfattningskvaliteten är imponerande och kan ofta mäta sig med den hos proprietära modeller. Nackdelen är behovet av teknisk infrastruktur. Ditt team kommer att behöva tekniska resurser för att distribuera och underhålla modellen, eftersom det inte finns någon färdig API tillgänglig. Detta gör den perfekt för teknikdrivna eller integritetsfokuserade organisationer.

LLaMA 3:s bästa funktioner

- Fullständig datakontroll med självhostad distribution

- Finjusteringsfunktion för domänspecifik terminologi

- Inga licensavgifter för kommersiellt bruk.

Begränsningar för LLaMA 3

- Kräver betydande teknisk infrastruktur för att implementeras.

- Inget hanterat API – ditt team sköter underhållet

- Komplexiteten i den initiala installationen kan fördröja tid till värde.

Priser för LLaMA 3

- Gratis att använda med öppen källkodslicens.

- Infrastrukturkostnaderna beror på valet av värdtjänst.

6. Mistral Large (bäst för EU:s krav på datalagring)

Vad händer om du vill ha flexibiliteten hos öppen källkod men inte har resurserna att hantera infrastrukturen själv? Mistral Large erbjuder en övertygande medelväg. Den är utvecklad av ett europeiskt företag och levererar konkurrenskraftig sammanfattningsprestanda med starkt fokus på effektivitet.

Mistral erbjuder både en hanterad API för enkel åtkomst och öppna viktmodeller för team som vill ha mer kontroll. Denna hybridstrategi är dess främsta fördel. Nackdelen är ett mindre ekosystem av tredjepartsintegrationer jämfört med jättar som OpenAI och Google. Det är ett utmärkt val för team som söker en balans mellan bekvämlighet och kontroll, särskilt de som har EU:s krav på datalagring.

Mistral Larges bästa funktioner

- Hybridåtkomst via hanterad API eller egenhostad distribution

- Stark prestanda med efterlevnad av europeiska datalagringskrav

- Konkurrenskraftiga priser jämfört med stora proprietära modeller

Begränsningar för Mistral Large

- Mindre integrationssystem än OpenAI eller Google

- Mindre omfattande dokumentation och communityresurser

Priser för Mistral Large

- API-åtkomst med konkurrenskraftiga priser per token

- Öppna viktmodeller tillgängliga för självhosting

💡 Proffstips: Om ditt huvudmål är att sammanfatta timslånga mötesprotokoll i ett svep, prioritera modeller med det största kontextfönstret, som Gemini 1. 5 Pro. Om du behöver lära modellen din företags specifika terminologi är ett open source-alternativ som LLaMA 3 det rätta valet.

💡 Proffstips: Om ditt huvudmål är att sammanfatta timslånga mötesprotokoll i ett svep, prioritera modeller med det största kontextfönstret, som Gemini 1. 5 Pro. Om du behöver lära modellen din företags specifika terminologi är ett open source-alternativ som LLaMA 3 det rätta valet.

Jämförelse av LLM-sammanfattningsmodeller

Snabb jämförelse hjälper dig att snabbt identifiera vilken modell som passar bäst för ditt teams högsta prioritet.

ClickUp Brain integrerar sammanfattning direkt i ditt arbetsflöde som en konvergerad AI-arbetsyta, vilket är perfekt för att omvandla sammanfattningar till omedelbara åtgärder. Den största nackdelen är att den fungerar optimalt inom ClickUp-ekosystemet.

GPT-4o erbjuder ett stort kontextfönster som en egenutvecklad modell, som är bäst för polerade och nyanserade sammanfattningar, med användningsbaserad prissättning som viktigaste avvägning.

Claude 3. 5 Sonnet erbjuder ett utökat kontextfönster som en egenutvecklad modell, idealisk för dokument som kräver efterlevnad av regler och där regional tillgänglighet är den primära begränsningen.

Gemini 1. 5 Pro levererar ett enormt kontextfönster som en egenutvecklad modell, perfekt för Google Workspace-användare, även om ekosystemets inlåsning kan vara ett problem.

LLaMA 3 inkluderar ett stort kontextfönster som en öppen källkodsmodell, lämplig för självhostade anpassningsbara pipelines, men kräver investeringar i infrastruktur.

Mistral Large har ett stort kontextfönster med en hybridåtkomstmetod, vilket är utmärkt för EU:s krav på datalagring, men har ett mindre integrationssystem.

📖 Läs också: Bästa AI-transkriptionssammanfattare

Hur man utvärderar kvaliteten på LLM-sammanfattningar

För att veta om en modells sammanfattningar faktiskt är bra krävs ett tydligt utvärderingsramverk. Att förlita sig på en dålig sammanfattning kan vara värre än att inte ha någon sammanfattning alls, vilket kan leda till dåliga beslut baserade på felaktig information.

Viktiga kriterier för utvärdering

Noggrannhet avgör om sammanfattningen korrekt återger huvudpunkterna i originaltexten utan att hitta på fakta eller göra fel. Detta är ett måste för affärskritiska dokument.

Sammanhang mäter om sammanfattningen är lättläst och logisk, eller om den känns som en samling osammanhängande meningar. Bra sammanfattningar behåller berättelsestrukturen.

Koncisthet bedömer om sammanfattningen går rakt på sak eller är fylld med fluff och onödiga ord. De bästa sammanfattningarna maximerar informationsdensiteten.

Instruktionsföljande testar om modellen framgångsrikt kan följa dina önskemål om specifika tonfall, format eller fokusområden, såsom punktlistor eller sammanfattningar i ledningsstil.

Konsistens utvärderar om modellen producerar sammanfattningar av hög kvalitet för olika dokumenttyper eller om den bara fungerar bra för vissa typer.

Ett enkelt testramverk

Välj tre dokument som ditt team arbetar med regelbundet – en projektbeskrivning, ett mötesprotokoll och en e-posttråd från en kund. Kör varje dokument genom de modeller du överväger med samma prompt. Låt sedan en teammedlem betygsätta resultaten utifrån ovanstående kriterier. Även om det finns automatiserade mätvärden, finns det inget som slår en mänsklig granskning när det gäller att upptäcka subtila fel.

🔍 Visste du att? Team som QubicaAMF har sparat över 5 timmar per vecka med hjälp av ClickUp – det är över 250 timmar per person och år – genom att eliminera föråldrade processer för kunskapshantering. Tänk vad ditt team skulle kunna åstadkomma med en extra produktiv vecka varje kvartal.

🔍 Visste du att? Team som QubicaAMF har sparat över 5 timmar per vecka med hjälp av ClickUp – det är över 250 timmar per person och år – genom att eliminera föråldrade processer för kunskapshantering. Tänk dig vad ditt team skulle kunna åstadkomma med en extra produktiv vecka varje kvartal.

Vilka är begränsningarna med att använda LLM för dokumentsammanfattning?

Denna teknik har verkliga begränsningar som är värda att förstå innan du bestämmer dig för en viss metod.

Risker för hallucinationer

Den största risken är hallucination, där modellen med säkerhet anger felaktiga detaljer som låter trovärdiga. Juridiska team, finansanalytiker och alla som arbetar med dokument som är känsliga ur compliance-synpunkt bör alltid låta en människa granska sammanfattningar som har stor betydelse.

Kontextfönsterbegränsningar

Även de största modellerna har sina begränsningar, så extremt långa dokument kan behöva delas upp i mindre delar. Denna uppdelning kan leda till att modellen missar kopplingar mellan avlägset belägna avsnitt eller förlorar den övergripande berättarstrukturen.

Förlust av nyanser

Subtila argument eller minoritetsåsikter förflackas ofta i sammanfattningar. Om det är viktigt för ditt användningsfall att bevara avvikande åsikter eller gränsfall måste du utforma uppmaningar noggrant eller acceptera viss informationsförlust.

Utmaningar med domänspecifikitet

En allmän modell kanske inte förstår din branschs specifika jargong utan finjustering. Medicinska, juridiska och tekniska områden kräver ofta ytterligare träning eller noggrann prompt engineering.

Säkerhetsaspekter

Att skicka känslig företagsinformation till en tredjeparts API medför alltid en viss risk. För mycket konfidentiella dokument kan det vara nödvändigt med självhostade modeller eller företagsavtal med specifika villkor för datahantering.

Detta är inte skäl att undvika tekniken, men det är viktiga överväganden. Du kan mildra dem med smarta metoder: låt alltid en människa granska sammanfattningar som är viktiga, använd självhostade modeller för mycket känsliga data och använd tydliga uppmaningar för att hjälpa modellen att bevara viktiga nyanser.

📌 ClickUp Insight: 62 % av kunskapsarbetare förlitar sig på konversationsbaserade AI-verktyg som ChatGPT och Claude. Deras välbekanta chatbot-gränssnitt och mångsidiga förmågor kan förklara deras popularitet inom olika roller och branscher. Att byta till en annan flik för att ställa en fråga till AI varje gång medför dock extra kostnader för växling och kontextbyte.

📌 ClickUp Insight: 62 % av kunskapsarbetare förlitar sig på konversationsbaserade AI-verktyg som ChatGPT och Claude. Deras välbekanta chatbot-gränssnitt och mångsidiga funktioner kan förklara deras popularitet inom olika roller och branscher. Att varje gång byta till en annan flik för att ställa en fråga till AI:n medför dock extra kostnader för växling och kontextbyte.

Använd ClickUp Brain i ditt sammanfattningsarbetsflöde

Du har sett hur ClickUp Brain rankas bland de bästa LLM:erna för sammanfattning. Låt oss nu utforska hur man bygger arbetsflöden som omvandlar dessa sammanfattningar till verkliga produktivitetsvinster. Skillnaden mellan en användbar sammanfattning och bortkastad möda är om den kopplas till handling – och det är där Converged AI Workspace kommer till sin rätt.

[Bildplatshållare: ClickUp-arbetsyta som visar Brain-sammanfattning integrerad med uppgifter och dokument]

Få sammanfattningar direkt där du arbetar

Eliminera frustrerande manuella överlämningar genom att integrera sammanfattningar direkt i dina projekt. Med ClickUp Brain skriver du bara @brain i en uppgiftskommentar eller ett ClickUp Chat-meddelande och ber det att sammanfatta sammanhanget. Det ger omedelbart en sammanfattning med hjälp av sin kunskap om din arbetsyta och prioriterar den specifika uppgiften eller kanalen du befinner dig i.

Omvandla mötesinspelningar till åtgärdspunkter automatiskt

Att komma ikapp efter ett missat möte kräver inte längre timmar av läsning av anteckningar. Håll dig fullt engagerad i konversationerna medan ClickUp AI Notetaker antecknar mötet åt dig. Efter mötet tillhandahåller det en transkription och en sammanfattning. Du kan till och med be det att automatiskt generera åtgärdspunkter och omvandla dem till ClickUp-uppgifter med ansvariga och förfallodatum.

Utnyttja flera LLM utan att behöva hantera modellvalet

Få högkvalitativa resultat utan att själv behöva hantera modellvalet, eftersom ClickUp Brain använder flera LLM-modeller bakom kulisserna. Så här ser arbetsflödet ut i praktiken: Ett möte hålls, ClickUp AI Notetaker registrerar allt, ClickUp Brain sammanfattar de viktigaste besluten och åtgärdspunkterna finns redan i din projektplan. Du kan till och med använda @My Brain för att privat sammanfatta en tråd eller skriva ett svar innan du delar det med teamet.

✨ Verkliga resultat: Den verkliga utmaningen är att omsätta sammanfattningar i handling. ClickUp Brain är utmärkt på att koppla sammanfattningar direkt till uppgifter i ditt arbetsflöde, vilket eliminerar klyftan mellan insikt och genomförande som plågar fristående sammanfattningsverktyg.

✨ Verkliga resultat: Den verkliga utmaningen är att omsätta sammanfattningar i handling. ClickUp Brain är utmärkt på att koppla sammanfattningar direkt till uppgifter i ditt arbetsflöde, vilket eliminerar klyftan mellan insikt och genomförande som plågar fristående sammanfattningsverktyg.

Slutsats

Den bästa LLM för sammanfattning är den som passar ditt teams unika behov – oavsett om det är ett stort kontextfönster för långa rapporter, öppen källkodsflexibilitet för anpassning eller sömlös integration med dina befintliga verktyg. Innan du bestämmer dig bör du alltid testa dina bästa val med dina egna dokument från verkligheten för att se hur de fungerar.

Men kom ihåg att en sammanfattning bara är värdefull när den är kopplad till handling. Sammanfattning håller på att förvandlas från en fristående uppgift till en djupt integrerad funktion i de plattformar där du redan arbetar. Den verkliga produktivitetsvinsten kommer från att överbrygga klyftan mellan att få en insikt och att agera på den.

Kom igång gratis med ClickUp och integrera AI-sammanfattning direkt i din uppgiftshantering, chatt och dokument.

Vanliga frågor

Vad är skillnaden mellan extraktiv och abstraktiv LLM-sammanfattning? Extraktiv sammanfattning fungerar genom att dra ut nyckelfraser direkt från originaltexten, medan abstraktiv sammanfattning genererar helt nya meningar för att förmedla kärnbudskapet. Moderna LLM:er använder främst den abstrakta metoden, vilket resulterar i mer naturligt klingande sammanfattningar som bättre fångar essensen i källmaterialet.

Hur står sig öppen källkods-LLM i jämförelse med proprietära modeller som GPT-4 för sammanfattning? Öppen källkodsmodeller erbjuder fullständig kontroll över dina data och möjligheten att finjustera efter dina specifika behov, men de kräver tekniska resurser för underhåll. Proprietära modeller erbjuder bekvämlighet och användarvänlighet genom ett API, men medför användningskostnader och mindre kontroll över data. Kvalitetsskillnaden har minskat avsevärt, och open source-alternativ som LLaMA 3 konkurrerar med proprietära prestanda i många användningsfall.

Kan LLM-sammanfattningsverktyg hantera mötesanteckningar och projektuppdateringar? Ja, de flesta LLM-modeller är mycket effektiva när det gäller att sammanfatta konversationstext som mötesanteckningar. Den verkliga utmaningen är att omvandla dessa sammanfattningar till handling, och det är där verktyg som ClickUp Brain utmärker sig genom att koppla sammanfattningarna direkt till uppgifter i ditt arbetsflöde istället för att lämna dem som isolerade textdokument.

Vilken kontextfönsterstorlek behöver jag för mina dokument? För vanliga affärsdokument med färre än 10 000 ord har de flesta moderna LLM tillräckliga kontextfönster. För mötesprotokoll som är längre än en timme eller omfattande forskningsrapporter behöver du modeller med utökade kontextfönster, som Claude 3. 5 Sonnet eller Gemini 1. 5 Pro. Gemini 1. 5 Pros fönster på 1 miljon token kan hantera praktiskt taget alla sammanfattningsuppgifter för enskilda dokument.

Hur kan jag minska risken för hallucinationer i LLM-sammanfattningar? Använd tydliga, specifika uppmaningar som ber modellen att endast sammanfatta det som uttryckligen anges i källan. Begär citat eller referenser till specifika avsnitt när noggrannhet är avgörande. För dokument med hög risk bör du alltid låta en mänsklig granskare jämföra sammanfattningen med originalet. Överväg modeller med starkare säkerhetsanpassning, såsom Claude, när du arbetar med innehåll som är känsligt ur efterlevnadssynpunkt.