Har din AI-modell någonsin gett ett säkert svar som dina användare ansåg vara föråldrat? Det är den typen av upplevelser som leder till att ditt team ifrågasätter varje svar.

Det låter som varje utvecklares och AI-entusiasts mardröm, eller hur?

Stora språkmodeller (LLM) körs på träningsdata, men när data blir äldre smyger sig felaktigheter in. Eftersom omskolning kostar miljoner är optimering det smartare valet.

Retrieval Augmented Generation (RAG) och finjustering är de bästa ramverken för att öka noggrannheten. Men med tanke på skillnaderna mellan de olika metoderna är de idealiska för olika tillämpningar. Rätt ramverk är nyckeln till att effektivt förbättra din LLM.

Men vilken är rätt för dig?

Denna artikel behandlar dilemmat i denna guide om RAG kontra finjustering. Oavsett om du arbetar med domänspecifika data eller vill bygga högkvalitativa lösningar för datahämtning hittar du svaren här!

⏰60-sekunders sammanfattning

- Att förbättra prestandan hos LLM och AI-modeller är en viktig del av alla affärs- och utvecklingsfunktioner. RAG och finjustering är populära metoder, men det är viktigt att förstå deras nyanser och inverkan.

- RAG förser LLM med extern datahämtning i realtid, vilket minskar kostnaderna för omskolning.

- Fine-tuning optimerar LLM genom träning på specialiserade datamängder, vilket förbättrar noggrannheten för domänspecifika uppgifter.

- RAG är bäst för snabbt föränderliga datamiljöer som finans, juridiska uppdateringar och kundsupport.

- Fine-tuning är idealiskt för varumärkesspecifik AI, branscher med höga krav på regelefterlevnad och sentimentanalys.

- ClickUp Brain kombinerar båda metoderna och använder RAG för kontextuella insikter och finjustering för skräddarsydd automatisering och innehållsgenerering.

- ClickUps AI-drivna verktyg effektiviserar kunskapsinhämtning, automatisering av arbetsflöden och projektledning för maximal effektivitet.

Vad är Retrieval-Augmented Generation (RAG)?

Tittar du på nya rapporter och undersökningar som din LLM missade? Det är där du behöver RAG. För att förstå detta bättre, låt oss gå igenom grunderna i denna metod.

Definition av RAG

RAG är ett AI-ramverk som innebär ytterligare informationshämtning för din LLM för att förbättra svarens noggrannhet. Innan LLM genererar svar hämtar det de mest relevanta uppgifterna från externa källor, såsom kunskapskällor eller databaser.

Tänk på det som en forskningsassistent inom LLM eller generativ AI-modell.

👀 Visste du att? LLM, särskilt textgeneratorer, kan hallucinera genom att generera falsk men trovärdig information. Allt på grund av luckor i träningsdata.

Viktiga fördelar med RAG

Det är nog tydligt vid det här laget. RAG är ett extra lager av sammankopplad AI som din affärsprocess behöver. För att belysa dess potential, här är några av fördelarna:

- Minskade utbildningskostnader: Eliminerar behovet av frekvent omskolning av modeller tack vare dynamisk informationshämtning. Detta leder till en mer kostnadseffektiv AI-implementering, särskilt för områden med snabbt föränderliga data.

- Skalbarhet: Utökar LLM:s kunskap utan att öka storleken på det primära systemet. De hjälper företag att skala upp, hantera stora datamängder och köra fler sökningar utan höga datorkostnader.

- Uppdateringar i realtid: Återspeglar den senaste informationen i varje svar och håller modellen relevant. Att prioritera noggrannhet genom uppdateringar i realtid är avgörande i många verksamheter, inklusive finansiell analys, hälso- och sjukvård och efterlevnadsrevisioner.

📮 ClickUp Insight: Hälften av våra respondenter har svårt att införa AI; 23 % vet helt enkelt inte var de ska börja, medan 27 % behöver mer utbildning för att kunna göra något avancerat.

ClickUp löser detta problem med ett välbekant chattgränssnitt som känns precis som att skicka sms. Team kan direkt ställa enkla frågor och göra enkla förfrågningar, och sedan naturligt upptäcka mer kraftfulla automatiseringsfunktioner och arbetsflöden efter hand, utan den skrämmande inlärningskurva som hindrar så många människor.

Användningsfall för RAG

Undrar du var RAG kommer till sin rätt? Tänk på dessa viktiga användningsfall:

Chatbots och kundsupport

Kundfrågor kräver ofta aktuella och kontextmedvetna svar. RAG förbättrar chatbotens kapacitet genom att hämta de senaste supportartiklarna, policyerna och felsökningsstegen.

Detta möjliggör mer exakt hjälp i realtid utan omfattande förträning.

Dynamisk dokumenthämtning

RAG optimerar dokumentsökningen genom att hämta de mest relevanta avsnitten från stora arkiv. Istället för generiska sammanfattningar kan LLM ge precisa svar från uppdaterade manualer, forskningsrapporter eller juridiska dokument.

Genom att använda RAG-drivna LLM blir informationshämtningen snabbare och mer precis.

🧠 Kul fakta: Meta, som äger Facebook, Instagram, Threads och WhatsApp, introducerade RAG i LLM-utvecklingen 2020.

Vad är finjustering?

Låt oss titta närmare på vad finjustering innebär.

Definition av finjustering

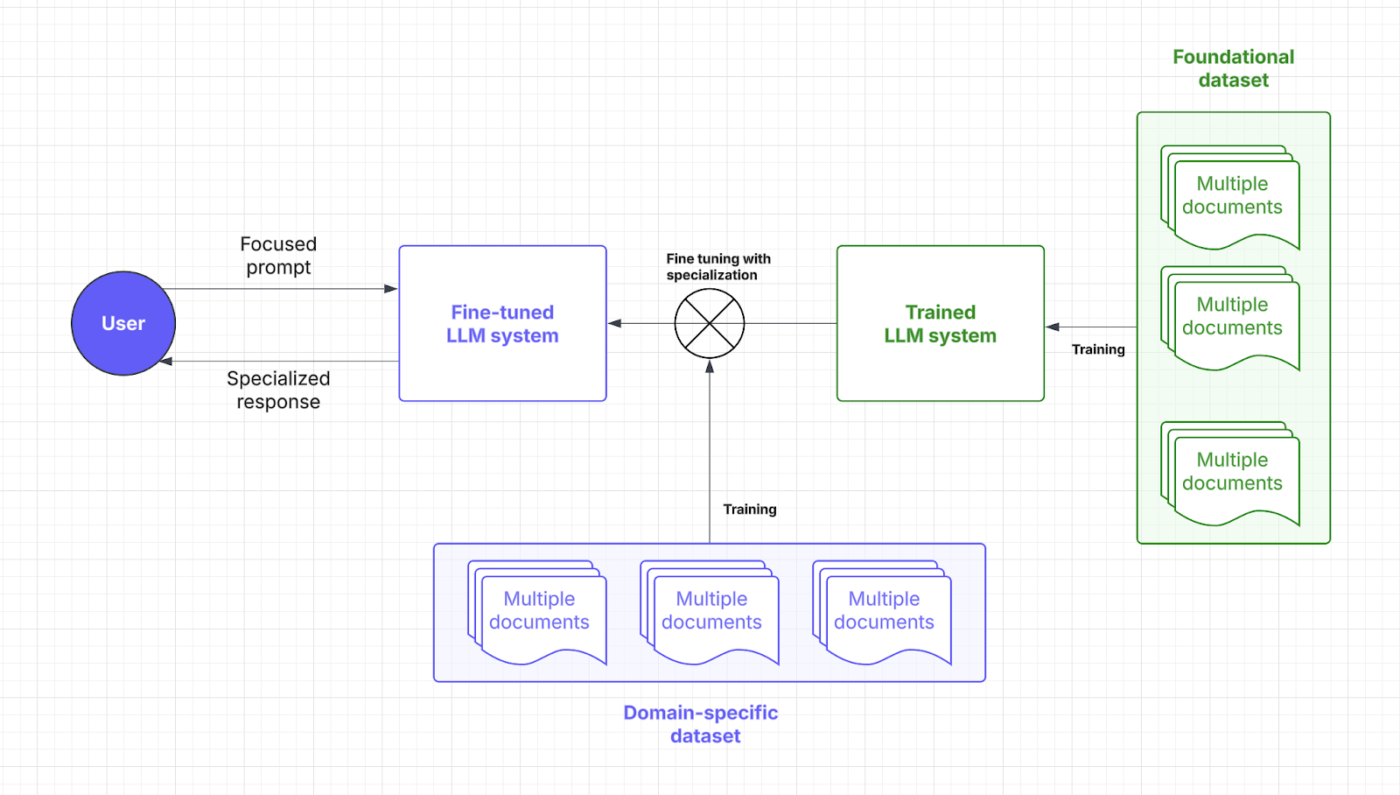

Fine-tuning innebär att träna en förtränad språkmodell. Ja, det krävs mycket träning, vilket kan förklaras med hjälp av punkt och fokus.

🧠 Visste du att: I träning av stora språkmodeller (LLM) är ”vikter” de justerbara parametrarna i det neurala nätverket som bestämmer styrkan i kopplingarna mellan neuroner och i huvudsak lagrar den inlärda informationen. Träningsprocessen optimerar dessa vikter för att minimera prediktionsfel.

”Fokus” omfattar å andra sidan flera aspekter: det handlar om noggrann datakurering för att säkerställa kvalitet och relevans, användning av uppmärksamhetsmekanismer för att prioritera relevanta insatsdelar och målinriktad finjustering för att specialisera modellen för specifika uppgifter.

Genom specialiserade datamängder gör finjustering det möjligt för AI-modeller att begränsa sig till att utföra domänspecifika uppgifter. Genom att justera modellens vikter och fokus får din LLM bättre kontextuell förståelse och noggrannhet.

Tänk på finjustering som den magisterexamen som din LLM behöver för att tala ditt branschspråk. Låt oss gå igenom var denna AI-strategi kommer in i processen för snabba svar:

Fördelar med finjustering

Fine-tuning-tekniker är bara justeringar av AI. Det är mer som att kunna zooma in på fördefinierade detaljer. Här är fördelarna med det:

- Uppgiftsspecifik optimering: Specialiserade datamängder skärper LLM-svaren för specifika uppgifter. Vill du hjälpa användarna att slippa komplexa frågor? Fine-tuning hjälper utvecklare att få skräddarsydda AI-lösningar.

- Förbättrad noggrannhet för nischapplikationer: Domänkunskap minskar fel och förbättrar precisionen i varje svar. Finjustering ökar också LLM:s tillförlitlighet, vilket gör att företag kan slappna av när det gäller mikrostyrning och manuell övervakning.

- Anpassning för varumärkesröst och efterlevnad: Fine-tuning lär LLM företagets termer, stil och regler. Detta upprätthåller en konsekvent varumärkesröst och branschspecifik efterlevnad.

Användningsfall för finjustering

Din finjusteringsprocess ger målinriktad effektivitet. Här är dess fördelar:

Domänspecifika QA-system

Branscher som juridik, hälso- och sjukvård och finans är beroende av precisa, domänmedvetna AI-svar. Finjustering förser LLM med specialiserad kunskap, vilket säkerställer korrekta svar på frågor (QA).

En juridisk AI-assistent kan till exempel tolka avtal mer exakt, medan en medicinsk chatbot kan ge symptombaserad vägledning med hjälp av tillförlitliga datamängder.

Sentimentanalys och anpassade arbetsflöden

Företag använder en finjusterad modell för att övervaka varumärken, analysera kundfeedback och automatisera arbetsflöden som är anpassade efter unika operativa behov. Ett AI-drivet verktyg kan upptäcka nyanserade åsikter i produktrecensioner, vilket hjälper företag att förfina sina erbjudanden.

Inom HR hjälper en kombination av finjustering och naturlig språkbehandling AI att analysera medarbetarundersökningar och flagga problem på arbetsplatsen med större kontextuell medvetenhet.

💡 Proffstips: Finjustering kan innebära att man lägger till mer varierad data för att eliminera potentiella fördomar. Det är inte direkt domänspecifikt, men ändå en viktig tillämpning.

Jämförelse: RAG vs. finjustering

Det går inte att förneka att båda AI-strategierna syftar till att öka prestandan.

Men valet verkar fortfarande ganska svårt, eller hur? Här är en jämförelse mellan finjustering och RAG som hjälper dig att fatta rätt beslut för dina LLM-investeringar.

| Aspekt | RAG (Retrieval-augmented generation) | Finjustering |

| Definition | Gör det möjligt för LLM att hämta relevant data i realtid från externa källor med sitt dedikerade system. | Tränar en förtränad modell med specialiserade datamängder för domänspecifika uppgifter |

| Prestanda och noggrannhet | Utmärkt för hämtning av data i realtid, men noggrannheten beror på kvaliteten på externa data. | Förbättrar kontextuell noggrannhet och uppgiftsspecifika svar |

| Kostnad och resursbehov | Mer kostnadseffektivt initialt fokus på realtidsåtkomst till data | Kräver mer resurser för initial träning, men är kostnadseffektivt på lång sikt. |

| Underhåll och skalbarhet | Mycket skalbar och flexibel, men beroende av uppdateringsfrekvensen för externa källor. | Kräver frekventa uppdateringar och underhåll, men erbjuder stabil prestanda på lång sikt. |

| Användningsfall | Chatbots, dynamisk dokumenthämtning, realtidsanalys | Domänspecifika QA-system, sentimentanalys och anpassning av varumärkets röst |

| När ska man välja | Snabbt föränderliga data, uppdateringar i realtid och prioritering av resurskostnader | Nischade kundsegment, domänspecifik logik, varumärkesspecifik anpassning |

| Idealisk för | Branscher behöver korrekt information i realtid (finans, juridik, kundsupport) | Branscher som kräver specifikt språk, efterlevnad eller sammanhang (hälso- och sjukvård, juridik, HR) |

Behöver du lite mer klarhet för att lösa dina tvivel? Här är en jämförelse av viktiga aspekter som påverkar dina behov.

Prestanda och noggrannhet

När det gäller prestanda spelar RAG en viktig roll genom att hämta in nya data från externa källor. Dess noggrannhet och svarstider beror på kvaliteten på dessa data. Tack vare detta beroende av externa databaser kan RAG leverera aktuell information på ett effektivt sätt.

Fine-tuning, å andra sidan, förbättrar hur modellen bearbetar och svarar genom specialiserad omskolning. Denna process ger mer kontextuellt korrekta svar, särskilt för nischapplikationer. Finjusterade LLM är idealiska för att upprätthålla konsistens i branscher med strikta krav, såsom hälso- och sjukvård eller finans.

Slutsats: RAG är utmärkt för realtidsdata och finjustering för kontextuellt korrekta svar.

En Reddit-användare säger:

Om du använder en liten modell och en bra databas i RAG-pipeline kan du generera högkvalitativa dataset, bättre än att använda utdata från en högkvalitativ AI.

Om du använder en liten modell och en bra databas i RAG-pipeline kan du generera högkvalitativa datamängder, bättre än om du använder utdata från en högkvalitativ AI.

💡 Proffstips: För att styra din LLM mot ett specifikt resultat, fokusera på effektiv, snabb teknik.

Kostnads- och resursbehov

RAG är vanligtvis mer kostnadseffektivt i förväg eftersom det bara lägger till ett lager för hämtning av extern data. Genom att undvika behovet av att omskola hela modellen framstår det som ett mycket mer budgetvänligt alternativ, särskilt i dynamiska miljöer. Driftskostnaderna för realtidsåtkomst och lagring av data kan dock bli höga.

Fine-tuning kräver mer förberedelse av dataset och träningsresurser, men är en långsiktig investering. När LLM har finjusterats behöver de färre uppdateringar, vilket leder till förutsägbar prestanda och kostnadsbesparingar. Utvecklare bör väga den initiala investeringen mot löpande driftskostnader.

Slutsats: RAG är kostnadseffektivt, enkelt att implementera och ger snabba fördelar. Finjustering är resurskrävande i början, men förbättrar LLM-kvaliteten och sparar driftskostnader på lång sikt.

💡 Proffstips: Ditt RAG-system är bara så smart som de data det hämtar från. Håll dina källor rena och fyll dem med korrekta, uppdaterade data!

Underhåll och skalbarhet

RAG erbjuder utmärkt skalbarhet eftersom fokus främst ligger på att utöka den externa källan. Dess flexibilitet och anpassningsförmåga gör den perfekt för snabbrörliga branscher. Underhållet beror dock på hur ofta externa databaser uppdateras.

Fine-tuning kräver ganska frekvent underhåll, särskilt när domänspecifik information ändras. Det kräver visserligen mer resurser, men ger större konsistens över tid och kräver gradvis färre justeringar. Däremot är skalbarheten för fine-tuning mycket mer komplex, eftersom den involverar mer omfattande och varierande datamängder.

Slutsats: RAG är bäst för snabb skalning och finjustering för minimalt underhåll och stabil prestanda.

En Reddit-användare tillägger:

När uppgiften är liten är det ofta mer effektivt att bara skaffa en större modell än att finjustera en mindre.

När uppgiften är liten är det ofta mer effektivt att bara skaffa en större modell än att finjustera en mindre.

👀 Visste du att? Det finns AI-lösningar som nu kan lukta. Med tanke på hur komplexa dofter är, kräver det mycket regelbunden finjustering och komplex datahämtning.

Vilken metod passar bäst för ditt användningsfall?

Trots att du förstår nyanserna kan det kännas svårt att fatta ett beslut utan tydliga referenser eller sammanhang. Låt oss gå igenom några affärsscenarier som visar hur varje AI-modell fungerar bäst.

När ska man välja RAG?

RAG hjälper dig att mata din LLM med rätt fakta och information, inklusive tekniska standarder, försäljningsstatistik, kundfeedback och mycket mer.

Hur kan du använda detta? Överväg följande scenarier för att införa RAG i din verksamhet:

Användningsfall nr 1: Realtidsanalys

- Scenario: Ett fintech-företag tillhandahåller AI-drivna marknadsinsikter för handlare. Användarna ställer frågor om aktietrender och systemet måste hämta de senaste marknadsrapporterna, SEC-dokument och nyheter.

- Varför RAG vinner: Aktiemarknaderna förändras snabbt, så det är dyrt och ineffektivt att ständigt omskola AI-modeller. RAG håller saker och ting uppdaterade genom att endast hämta de senaste finansiella uppgifterna, vilket sänker kostnaderna och ökar noggrannheten.

- Tumregel: RAG bör vara din strategi när AI hanterar snabbt föränderliga data. Populära tillämpningar är analys av data från sociala medier, energioptimering, upptäckt av cybersäkerhetshot och orderuppföljning.

Användningsfall nr 2: Datakontroller och efterlevnad av regelverk

- Scenario: En juridisk AI-assistent hjälper advokater att utarbeta avtal och verifiera efterlevnaden av nya lagar genom att hämta de senaste lagarna, prejudikaten och domarna.

- Varför RAG vinner: Verifiering av juridiska och kommersiella aspekter kräver inte djupgående beteendeuppdateringar. RAG gör jobbet ganska bra genom att hämta juridiska texter från en central dataset i realtid.

- Tumregel: RAG är utmärkt för resurs- och statistikbaserade insikter. Ett bra sätt att maximera detta är att använda medicinska AI-assistenter för behandlingsrekommendationer och kundchattbottar för felsökning och policyuppdateringar.

Undrar du fortfarande om du behöver RAG i din LLM? Här är en snabb checklista:

- Behöver du nya, högkvalitativa data utan att ändra LLM-modellen?

- Förändras din information ofta?

- Behöver din LLM arbeta med dynamisk information istället för statiska träningsdata?

- Vill du undvika stora kostnader och tidskrävande omskolning av modeller?

När finjustering är mer effektivt

Som vi nämnde tidigare är finjustering AI-högskola. Din LLM kan till och med lära sig branschjargong. Här är en branschspecifik spotlight på när den verkligen lyser:

Användningsfall nr 1: Lägga till varumärkets röst och tonfall

- Scenario: Ett lyxvarumärke skapar en AI-concierge för att interagera med kunderna på ett raffinerat och exklusivt sätt. Den måste förkroppsliga varumärkesspecifika tonfall, formuleringar och emotionella nyanser.

- Varför finjustering vinner: Finjustering hjälper AI-modellen att fånga upp och replikera varumärkets unika röst och ton. Det ger en konsekvent upplevelse i varje interaktion.

- Tumregel: Fine-tuning är effektivare om dina LLM måste anpassas till en specifik expertis. Detta är idealiskt för genreorienterade immersiva spel, tematisk och empatisk berättande eller till och med marknadsföringstexter för varumärken.

🧠 Kul fakta: LLM som tränats i sådana mjuka färdigheter är utmärkta på att analysera medarbetarnas känslor och tillfredsställelse. Men endast 3 % av företagen använder för närvarande generativ AI inom HR.

Användningsfall nr 2: Innehållsmoderering och kontextbaserade insikter

- Scenario: En social medieplattform använder en AI-modell för att upptäcka skadligt innehåll. Den fokuserar på att känna igen plattformsspecifikt språk, ny slang och kontextkänsliga överträdelser.

- Varför finjustering vinner: Mjuka färdigheter som meningsbyggnad ligger ofta utanför RAG-systemens räckvidd. Finjustering förbättrar LLM:s förståelse för plattformsspecifika nyanser och branschjargong, särskilt relevant innehållsmoderering.

- Tumregel: Det är klokt att välja finjustering när det gäller kulturella eller regionala skillnader. Detta gäller även anpassning till branschspecifika termer som medicinsk, juridisk eller teknisk jargong.

Ska du finjustera din LLM? Ställ dig själv dessa viktiga frågor:

- Behöver din LLM leverera till ett nischat kundsegment eller varumärkestema?

- Vill du lägga till egen eller domänspecifik data till LLM:s logik?

- Behöver du snabbare svar utan att förlora noggrannheten?

- Levererar dina LLM offline-lösningar?

- Kan du avsätta dedikerade resurser och datorkraft för omskolning?

Att förbättra användarupplevelsen är fantastiskt. Men många företag behöver också AI för att öka produktiviteten och motivera höga investeringskostnader. Därför är det ofta ett självklart val för många att använda en förtränad AI-modell.

👀 Visste du att? Gen AI har potential att automatisera arbetsuppgifter som sparar upp till 70 procent av medarbetarnas tid. Att effektivt be AI om insikter spelar en stor roll här!

Hur ClickUp utnyttjar avancerade AI-tekniker

Valet mellan RAG och finjustering är en ganska stor debatt.

Det räcker med att läsa några Reddit-trådar för att bli förvirrad. Men vem har sagt att du måste välja bara en?

Tänk dig att ha anpassningsbara AI-modeller, automatisering och uppgiftshantering på ett och samma ställe. Det är ClickUp, appen som har allt för arbetet. Den samlar projektledning, dokumentation och teamkommunikation under ett tak och drivs av nästa generations AI.

Kort sagt, den utmärker sig i allt, särskilt med sin omfattande AI-lösning: ClickUp Brain.

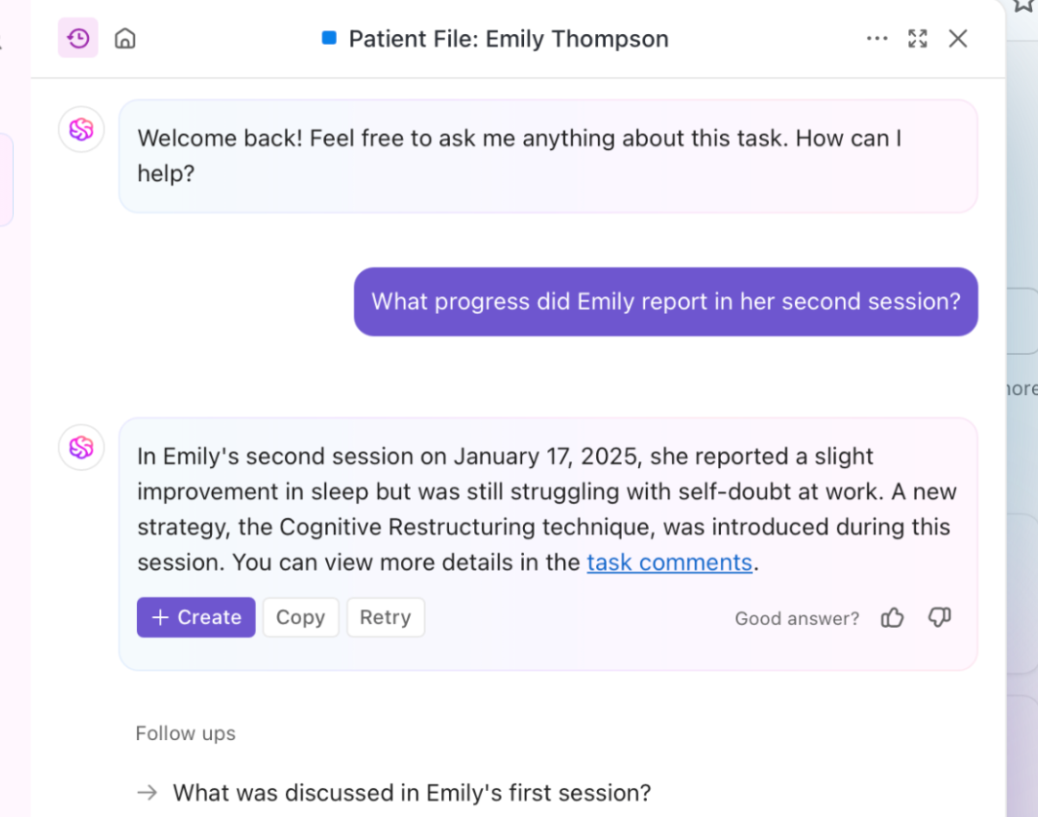

Behöver du snabba, kontextmedvetna insikter? Brain hämtar information i realtid från dina dokument, uppgifter och resurser. Det är RAG i praktiken. Dessutom kan dess grundläggande LLM, Brain, generera rapporter och rutinmässiga projektuppdateringar.

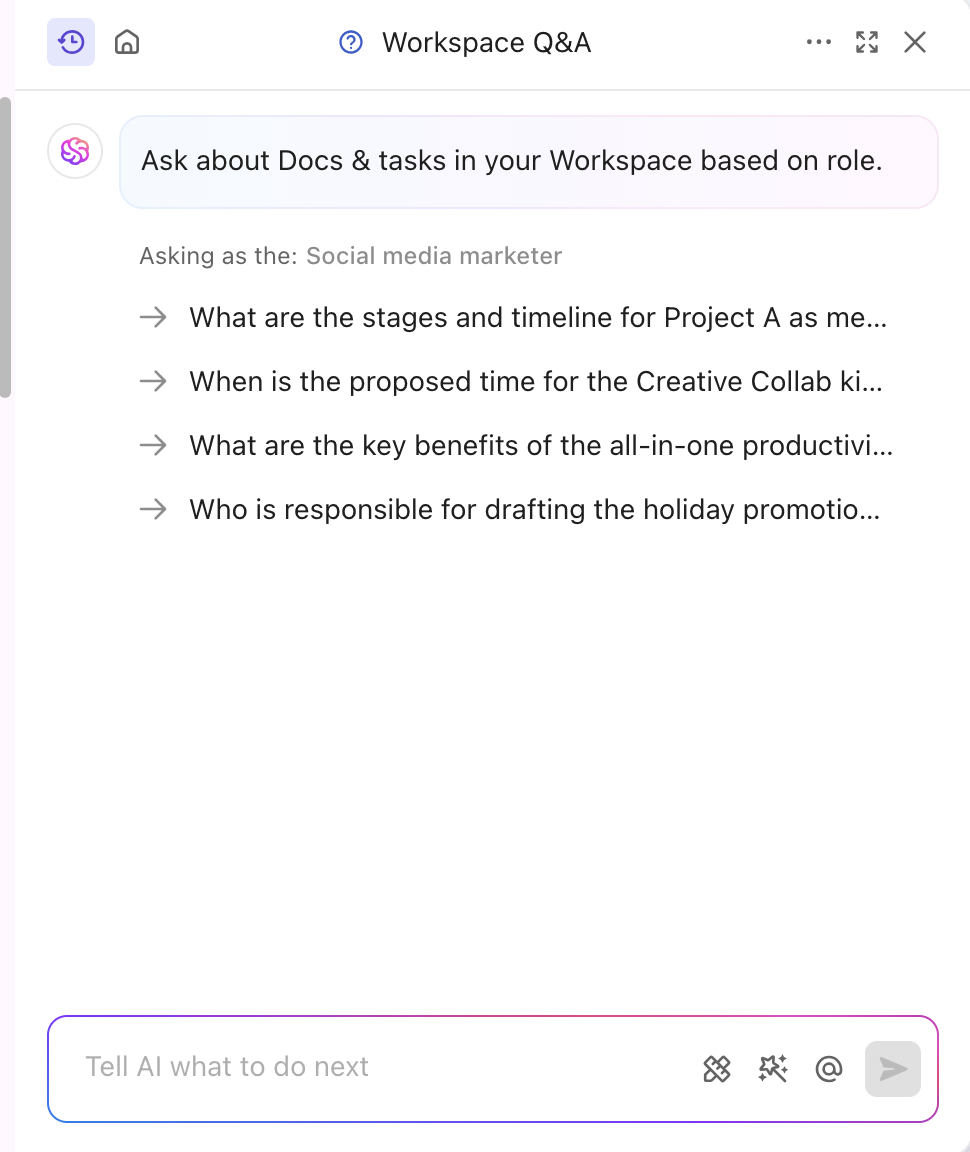

AI-verktyget är också finjusterat för att passa din bransch och ditt segment, och levererar professionella och kreativa insikter. Det personaliserar till och med innehållet i realtid utan någon manuell träning. Brain kombinerar finjustering och RAG för att automatisera projektuppdateringar, uppgiftsfördelning och arbetsflödesmeddelanden. Vill du ha svar som är skräddarsydda för din roll? ClickUp Brain kan göra det också!

Förutom att specialisera sig på innehåll, driver ClickUp också sin plattform med en kraftfull kunskapsbaserad AI-funktion.

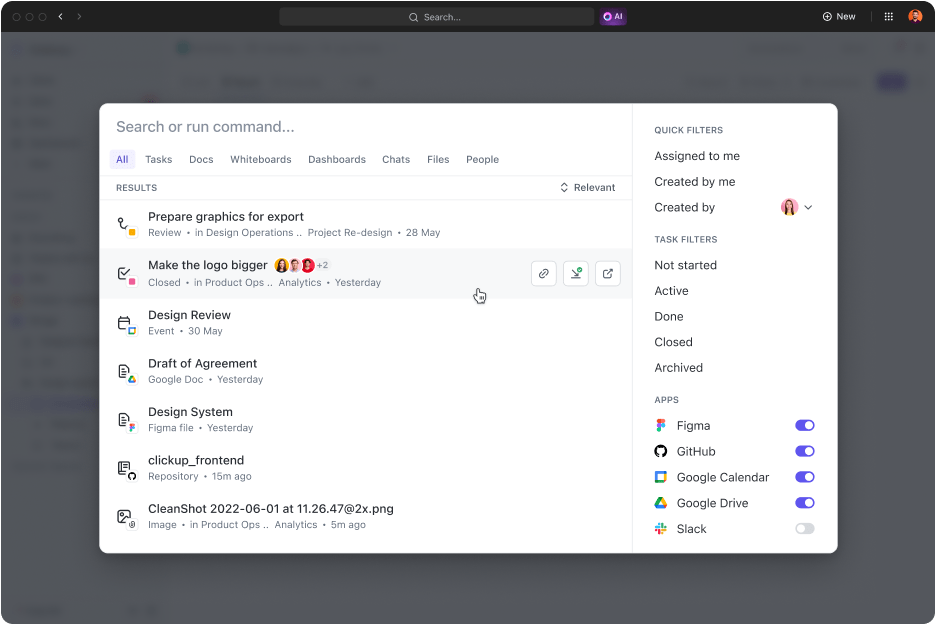

ClickUp Connected Search är ett AI-drivet verktyg som snabbt hämtar alla resurser från ditt integrerade utrymme. Oavsett om du behöver dokument för dagens standup eller svar på någon uppgift, så hämtar en enkel sökning källänkar, citat och detaljerade insikter.

Den startar också appar, söker i din urklippshistorik och skapar utdrag. Det bästa av allt? Allt detta är tillgängligt med ett klick från ditt kommandocenter, åtgärdsfält eller skrivbord.

Hum JAM:s vd, som är expert på digital marknadsföring, säger till och med att

ClickUp är det mest fantastiska ”allt-i-ett”-verktyget för teamautomatisering som spårar, automatiserar och mäter teamets framgångar. Tro mig när jag säger att ditt team inte kan klara sig utan detta verktyg.

ClickUp är det mest fantastiska ”allt-i-ett”-verktyget för teamautomatisering som spårar, automatiserar och mäter teamets framgångar. Tro mig när jag säger att ditt team inte kan klara sig utan detta verktyg.

Förbättra Gen AI och LLM-noggrannheten med ClickUp

RAG-kraftfulla svar, förfinade med färsk extern data och finjustering, används för specifika uppgifter och beteenden. Båda förbättrar AI-prestandan, men rätt tillvägagångssätt avgör din takt och effektivitet.

I dynamiska branscher handlar beslutet ofta om vilken metod man ska välja först. En kraftfull förtränad lösning är vanligtvis det klokaste valet.

Om du vill förbättra servicekvaliteten och produktiviteten är ClickUp en utmärkt partner. Dess AI-funktioner driver innehållsgenerering, datahämtning och analytiska svar. Dessutom kommer plattformen med över 30 verktyg som täcker allt från uppgiftshantering till att skapa fantastiska bilder.