Вашият AI модел някога давал ли е уверен отговор, който вашите потребители са определили като остарял? Това е вид опит, който кара вашия екип да поставя под съмнение всеки негов отговор.

Звучи като кошмар за всеки разработчик и ентусиаст на изкуствения интелект, нали?

Големите езикови модели (LLM) работят с данни от обучение, но с остаряването на данните се промъкват неточности. Тъй като преобучението струва милиони, оптимизацията е по-разумният ход.

Retrieval Augmented Generation (RAG) и финото настройване са най-добрите рамки за повишаване на точността. Въпреки това, предвид разликите между двата подхода, те са идеални за различни приложения. Подходящата рамка е ключът към ефективното подобряване на LLM.

Но кой от двата е подходящ за вас?

Тази статия разглежда дилемата в това ръководство за RAG и фино настройване. Независимо дали работите с данни, специфични за дадена област, или търсите да създадете висококачествени решения за извличане на данни, тук ще намерите отговорите!

⏰60-секундно резюме

- Подобряването на производителността на LLM и AI моделите е ключова част от всяка бизнес и разработваща функция. Макар RAG и финото настройване да са популярни подходи, е важно да се разберат техните нюанси и въздействие.

- RAG предоставя на LLM възможността за извличане на външни данни в реално време, което намалява разходите за преобучение.

- Fine-tuning оптимизира LLM чрез обучение на специализирани набори от данни, подобрявайки точността за задачи, специфични за дадена област.

- RAG е най-подходящ за бързо променящи се данни като финанси, правни актуализации и обслужване на клиенти.

- Fine-tuning е идеален за AI, специфична за дадена марка, индустрии с високи изисквания за съответствие и анализ на настроенията.

- ClickUp Brain съчетава и двете, като използва RAG за контекстуални прозрения и фина настройка за персонализирана автоматизация и генериране на съдържание.

- Инструментите на ClickUp, базирани на изкуствен интелект, ускоряват извличането на знания, автоматизацията на работния процес и управлението на проекти за максимална ефективност.

Какво е Retrieval-Augmented Generation (RAG)?

Разглеждате ли нови доклади и проучвания, които LLM не е използвал? Тогава се нуждаете от RAG. За да разберете по-добре това, нека разгледаме основите на този подход.

Определение на RAG

RAG е AI рамка, която включва допълнително извличане на информация за вашия LLM, за да подобри точността на отговорите. Преди генерирането на LLM отговори, тя извлича най-релевантните данни от външни източници, като източници на знания или бази данни.

Мислете за него като за изследователски асистент в рамките на LLM или генеративния AI модел.

👀 Знаете ли, че... LLM, особено генераторите на текст, могат да създават халюцинации, като генерират невярна, но правдоподобна информация. Всичко това се дължи на пропуски в данните за обучение.

Основни предимства на RAG

Вероятно вече е ясно. RAG е допълнителен слой от свързана изкуствена интелигентност, от която се нуждаят вашите бизнес процеси. За да подчертаем потенциала му, ето някои от предимствата, които предлага:

- Намалени разходи за обучение: Елиминира необходимостта от често преобучение на модела благодарение на динамичното извличане на информация. Това води до по-рентабилно внедряване на AI, особено за области с бързо променящи се данни.

- Мащабируемост: Разширява знанията на LLM, без да увеличава размера на основната система. Помагат на бизнеса да се мащабира, да управлява големи масиви от данни и да изпълнява повече заявки без високи разходи за изчислителни ресурси.

- Актуализации в реално време: Отразява най-новата информация във всеки отговор и поддържа актуалността на модела. Приоритизирането на точността чрез актуализации в реално време е от жизненоважно значение в много операции, включително финансови анализи, здравеопазване и одити за съответствие.

📮 ClickUp Insight: Половината от нашите респонденти се борят с внедряването на AI; 23% просто не знаят откъде да започнат, а 27% се нуждаят от повече обучение, за да правят нещо по-сложно.

ClickUp решава този проблем с познат чат интерфейс, който прилича на изпращане на текстови съобщения. Екипите могат да започнат веднага с прости въпроси и заявки, а след това естествено да открият по-мощни функции за автоматизация и работни процеси, без да се налага да преминават през сложния процес на обучение, който спира толкова много хора.

Примери за използване на RAG

Чудите се къде RAG блести? Разгледайте тези ключови случаи на употреба:

Чатботове и обслужване на клиенти

Запитванията на клиентите често изискват актуални и съобразени с контекста отговори. RAG подобрява възможностите на чатбота, като извлича най-новите статии за поддръжка, политики и стъпки за отстраняване на проблеми.

Това позволява по-точна помощ в реално време без обширно предварително обучение.

Динамично извличане на документи

RAG оптимизира търсенето на документи, като извлича най-релевантните части от обширни хранилища. Вместо общи обобщения, LLM могат да предоставят точни отговори от актуализирани наръчници, изследователски документи или правни документи.

Прилагането на LLM, базирани на RAG, прави извличането на информация по-бързо и по-прецизно.

🧠 Интересен факт: Meta, която притежава Facebook, Instagram, Threads и WhatsApp, въведе RAG в разработката на LLM през 2020 г.

Какво е Fine-Tuning?

Нека разгледаме какво прави финото настройване.

Определение на фина настройка

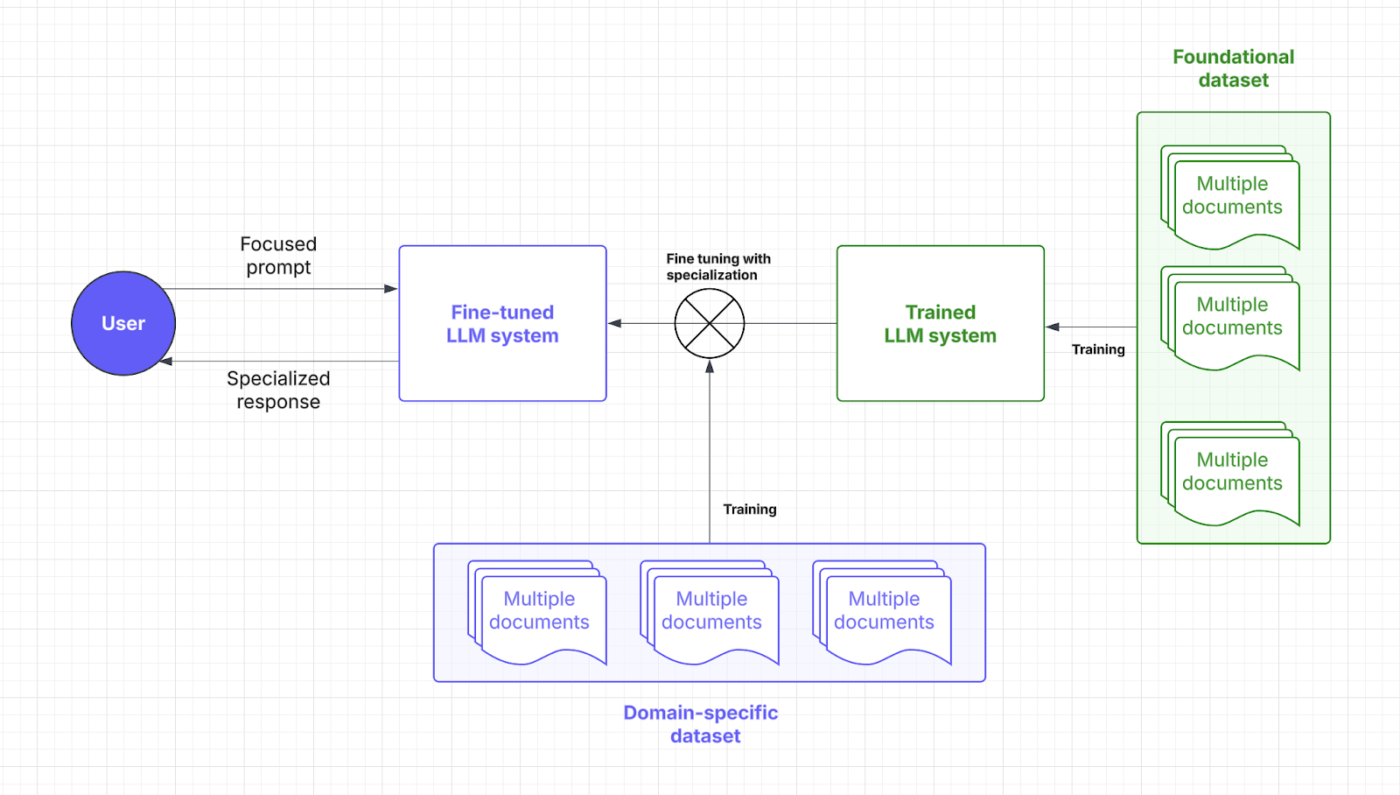

Fine-tuning включва обучение на предварително обучен езиков модел. Да, много обучение, което може да се обясни чрез точка и фокус.

🧠 Знаете ли, че: При обучението на големи езикови модели (LLM) „тежестите“ са регулируемите параметри в невронната мрежа, които определят силата на връзките между невроните, като по същество съхраняват научената информация; процесът на обучение оптимизира тези тежести, за да сведе до минимум грешките в прогнозите.

„Фокусът“, от друга страна, обхваща няколко аспекта: включва внимателно подбиране на данни, за да се гарантира качеството и релевантността, използване на механизми за внимание, за да се даде приоритет на релевантните сегменти от входните данни, и целенасочено фино настройване, за да се специализира моделът за конкретни задачи.

Чрез специализирани набори от данни, финото настройване позволява на AI моделите да се фокусират върху изпълнението на задачи, специфични за дадена област. Чрез коригиране на тежестта и фокуса на модела, вашият LLM придобива по-добро разбиране на контекста и по-голяма точност.

Помислете за финото настройване, от което LLM се нуждае, за да говори езика на вашата индустрия. Нека разгледаме къде тази AI стратегия влиза в процеса на бърза реакция:

Предимства на финото настройване

Техниките за фина настройка са просто оптимизиране на изкуствения интелект. По-скоро е като възможност за увеличаване на предварително определени детайли. Ето предимствата, които предлага:

- Оптимизация за конкретни задачи: Специализираните набори от данни подобряват отговорите на LLM за конкретни задачи. Искате да помогнете на потребителите да се отърват от главоболието, свързано с комплексните команди? Fine-tuning помага на разработчиците да получат персонализирани AI решения.

- Подобрена точност за нишови приложения: Знанията в дадена област намаляват грешките и повишават точността на всеки отговор. Fine-Tuning също така увеличава надеждността на LLM, което позволява на бизнеса да се отпусне по отношение на микроуправлението и ръчния надзор.

- Персонализиране за гласа на марката и съответствие: Fine-tuning учи LLM термините, стила и правилата на компанията. Това поддържа последователен глас на марката и съответствие, специфично за индустрията.

➡️ Прочетете също: Техники за изкуствен интелект: овладяване на машинно обучение, дълбоко обучение и NLP

Примери за използване на Fine-Tuning

Вашият процес на фина настройка отключва целева ефективност. Ето къде се отличава:

Системи за QA, специфични за дадена област

Сектори като правото, здравеопазването и финансите разчитат на прецизни, съобразени с областта отговори на AI. Fine-tuning обогатява LLM с специализирани знания, гарантирайки точни отговори на въпроси (QA).

Например, юридическият AI асистент може да интерпретира договорите по-прецизно, докато медицинският чатбот може да предоставя насоки въз основа на симптомите, използвайки надеждни набори от данни.

Анализ на настроенията и персонализирани работни процеси

Бизнесът използва фино настроен модел за наблюдение на марки, анализ на обратна връзка от клиенти и автоматизиране на работни процеси, съобразени с уникалните оперативни нужди. Инструмент, задвижван от изкуствен интелект, може да открива нюанси в настроенията в рецензиите за продукти, помагайки на компаниите да усъвършенстват своите предложения.

В областта на човешките ресурси комбинирането на фино настройване с обработка на естествен език помага на изкуствения интелект да анализира анкетите на служителите и да отбелязва проблемите на работното място с по-голяма контекстуална осведоменост.

💡 Професионален съвет: Fine-tuning може да включва добавяне на по-разнообразни данни, за да се премахнат потенциалните пристрастия. Това не е точно специфично за дадена област, но все пак е изключително важно приложение.

Сравнение: RAG срещу Fine-Tuning

Няма съмнение, че и двете AI стратегии имат за цел да подобрят производителността.

Но изборът все още изглежда доста труден, нали? Ето сравнение между фино настройване и RAG, което ще ви помогне да вземете правилното решение за вашите LLM инвестиции.

| Аспект | RAG (Retrieval-augmented generation) | Fine-tuning |

| Определение | Позволява на LLM да извлича в реално време релевантни данни от външни източници с помощта на специалната си система. | Обучава предварително обучен модел със специализирани набори от данни за задачи, специфични за дадена област. |

| Производителност и точност | Отлично за извличане на данни в реално време, но точността зависи от качеството на външните данни. | Подобрява контекстуалната точност и отговорите, специфични за задачата. |

| Изисквания за разходи и ресурси | По-рентабилен от начало фокус върху достъпа до данни в реално време | Изисква повече ресурси за първоначално обучение, но е рентабилен в дългосрочен план. |

| Поддръжка и мащабируемост | Високо мащабируем и гъвкав, но зависи от честотата на актуализациите на външни източници. | Изисква чести актуализации и поддръжка, но предлага стабилна дългосрочна производителност. |

| Примери за употреба | Чатботове, динамично извличане на документи, анализ в реално време | Системи за QA, специфични за дадена област, анализ на настроенията и персонализиране на гласа на марката |

| Кога да изберете | Бързо променящи се данни, актуализации в реално време и приоритизиране на разходите за ресурси | Нишови клиентски сегменти, специфична за домейна логика, специфична за марката персонализация |

| Идеален за | Индустриите се нуждаят от точна информация в реално време (финанси, право, обслужване на клиенти) | Сектори, изискващи специфичен език, съответствие или контекст (здравеопазване, право, човешки ресурси) |

Имате нужда от малко повече яснота, за да разсеете съмненията си? Ето едно сравнение на ключовите аспекти, които оказват влияние върху вашите нужди.

Производителност и точност

Когато става въпрос за производителност, RAG играе ключова роля, като извлича нови данни от външни източници. Неговата точност и време за отговор зависят от качеството на тези данни. Тази зависимост от външни бази данни позволява на RAG да предоставя ефективно актуална информация.

От друга страна, финото настройване подобрява начина, по който моделът обработва и отговаря чрез специализирано преобучение. Този процес дава по-точни отговори в контекста, особено за нишови приложения. Фино настроените LLM са идеални за поддържане на последователност в индустрии със строги изисквания, като здравеопазването или финансите.

Заключение: RAG е чудесен за данни в реално време, а Fine-Tuning – за контекстуално точни отговори.

Един потребител на Reddit казва:

Ако използвате малък модел и добра база данни в RAG тръбопровода, можете да генерирате висококачествени набори от данни, по-добри от тези, получени от висококачествена AI.

Ако използвате малък модел и добра база данни в RAG тръбопровода, можете да генерирате висококачествени набори от данни, по-добри от тези, получени от висококачествена AI.

💡 Професионален съвет: За да насочите LLM към конкретен резултат, се фокусирайте върху ефективно и бързо инженерство.

Изисквания за разходи и ресурси

RAG обикновено е по-рентабилен в началото, тъй като добавя само един слой за извличане на външни данни. Като се избягва необходимостта от преобучение на целия модел, той се очертава като много по-икономичен вариант, особено в динамични среди. Оперативните разходи за достъп до данни в реално време и съхранение обаче могат да се натрупат.

Fine-tuning изисква повече подготовка на набори от данни и ресурси за обучение, но е дългосрочна инвестиция. След като бъдат фино настроени, LLM се нуждаят от по-малко актуализации, което води до предвидима производителност и икономия на разходи. Разработчиците трябва да преценят първоначалната инвестиция спрямо текущите оперативни разходи.

Заключение: RAG е икономичен, лесен за внедряване и дава бързи резултати. Fine-tuning изисква повече ресурси в началото, но подобрява качеството на LLM и спестява оперативни разходи в дългосрочен план.

💡 Професионален съвет: Вашата RAG система е толкова умна, колкото данните, от които черпи информация. Поддържайте източниците си чисти и ги напълнете с точни и актуални данни!

Поддръжка и мащабируемост

RAG предлага отлична мащабируемост, тъй като фокусът е основно върху разширяването на външния източник. Гъвкавостта и адаптивността му го правят идеален за бързоразвиващите се индустрии. Поддръжката обаче зависи от честотата на актуализациите на външните бази данни.

Fine-tuning изисква доста честа поддръжка, особено когато се променя информацията, специфична за дадена област. Макар да изисква повече ресурси, той осигурява по-голяма последователност във времето и постепенно изисква по-малко корекции. Въпреки това, мащабируемостта за fine-tuning е много по-сложна и включва по-обширни и разнообразни набори от данни.

Заключение: RAG е най-подходящ за бързо мащабиране и фино настройване за минимална поддръжка и стабилна работа.

Потребител на Reddit добавя:

Когато задачата е малка, често е по-ефективно просто да се използва по-голям модел, отколкото да се фино настройва по-малък.

Когато задачата е малка, често е по-ефективно просто да се използва по-голям модел, вместо да се фино настройва по-малък.

👀 Знаете ли, че... Съществуват AI решения, които вече могат да миришат. Предвид сложността на ароматите, това изисква много редовно фино настройване и сложно извличане на данни.

Кой подход е подходящ за вашия случай?

Въпреки че разбирате нюансите, вземането на решение може да ви се стори безсмислено без ясна референция или контекст. Нека разгледаме няколко бизнес сценария, които подчертават как всеки AI модел работи по-добре.

Кога да изберете RAG

RAG помага да захранвате LLM с подходящи факти и информация, включително технически стандарти, записи за продажби, обратна връзка от клиенти и др.

Как да приложите това на практика? Разгледайте следните сценарии за внедряване на RAG във вашите операции:

Пример за употреба № 1: Анализ в реално време

- Сценарий: Финтех компания предоставя на трейдърите пазарни анализи, базирани на изкуствен интелект. Потребителите задават въпроси за тенденциите на пазара, а системата трябва да извлече най-новите пазарни доклади, документи, подадени в SEC, и новини.

- Защо RAG печели: Фондовите пазари се променят бързо, така че постоянното преобучение на AI моделите е скъпо и неефективно. RAG поддържа нещата в добро състояние, като извлича само най-актуалните финансови данни, намалява разходите и повишава точността.

- Практическо правило: RAG трябва да бъде вашата стратегия за AI, която обработва бързо променящи се данни. Популярни приложения са анализът на данни от социални медии, оптимизацията на енергията, откриването на заплахи за киберсигурността и проследяването на поръчки.

Пример за употреба № 2: Проверка на данни и спазване на нормативните изисквания

- Сценарий: Правният AI асистент помага на адвокатите да изготвят договори и да проверят съответствието с променящите се закони, като извлича най-новите закони, прецеденти и решения.

- Защо RAG печели: Проверката на правните и търговските аспекти не изисква задълбочени актуализации на поведението. RAG се справя доста добре с тази задача, като извлича правни текстове от централен набор от данни в реално време.

- Практическо правило: RAG се отличава с ресурсни и статистически базирани прозрения. Чудесен начин да максимизирате това е да използвате медицински AI асистенти за препоръки за лечение и чатботове за клиенти за отстраняване на проблеми и актуализиране на политики.

Все още се чудите дали имате нужда от RAG във вашия LLM? Ето един бърз списък за проверка:

- Имате ли нужда от нови, висококачествени данни, без да променяте самия LLM?

- Информацията ви се променя ли често?

- Вашият LLM трябва ли да работи с динамична информация вместо със статични данни за обучение?

- Искате ли да избегнете големи разходи и отнемащо време преобучение на модела?

➡️ Прочетете също: Най-добрите инструменти за инженеринг на подсказки за генеративна AI

Когато Fine-tuning е по-ефективен

Както споменахме по-рано, финото настройване е като магистърска програма по изкуствен интелект. Вашият LLM може дори да научи жаргона на индустрията. Ето един поглед върху индустрията, в която той наистина блести:

Пример за употреба № 1: Добавяне на глас и тоналност на марката

- Сценарий: Луксозна марка създава AI консиерж, който да общува с клиентите в изискан и ексклузивен тон. Той трябва да въплъщава специфичните за марката тоналности, изразни средства и емоционални нюанси.

- Защо финото настройване печели: Финото настройване помага на AI модела да улови и възпроизведе уникалния глас и тон на марката. То осигурява последователно преживяване при всяко взаимодействие.

- Практическо правило: Fine-tuning е по-ефективен, ако вашите LLM трябва да се адаптират към специфична експертиза. Това е идеално за жанрово ориентирани потапящи игри, тематично и емпатично разказване на истории или дори маркетингови текстове за марки.

🧠 Интересен факт: LLM, обучени в такива меки умения, се отличават в анализирането на настроенията и удовлетвореността на служителите. Но само 3% от бизнеса в момента използват генеративна AI в HR.

Пример за употреба № 2: Модерация на съдържание и контекстни прозрения

- Сценарий: Социална медийна платформа използва AI модел за откриване на вредно съдържание. Той се фокусира върху разпознаването на специфичен за платформата език, нововъзникващ жаргон и нарушения, свързани с контекста.

- Защо финото настройване печели: Меките умения като формулирането на изречения често са извън обхвата на RAG системите. Финото настройване подобрява разбирането на LLM за специфичните за платформата нюанси и жаргона на индустрията, особено по отношение на модерацията на съдържанието.

- Практическо правило: Изборът на фино настройване е разумно решение, когато се занимавате с културни или регионални различия. Това важи и за адаптирането към специфични за дадена индустрия термини, като медицински, правни или технически жаргон.

На път сте да фино настроите LLM? Задайте си следните ключови въпроси:

- Вашият LLM трябва ли да обслужва нишова клиентска група или бранд тема?

- Искате ли да добавите собствени или специфични за домейна данни към логиката на LLM?

- Имате ли нужда от по-бързи отговори, без да губите точност?

- Вашите LLM предоставят ли офлайн решения?

- Можете ли да отделите специални ресурси и изчислителна мощност за преобучение?

Подобряването на потребителското преживяване е чудесно. Много компании обаче се нуждаят от AI и като средство за повишаване на производителността, за да оправдаят високите инвестиционни разходи. Ето защо използването на предварително обучен AI модел често е предпочитаният избор за мнозина.

👀 Знаете ли, че... Gen AI има потенциал да автоматизира работните дейности, което спестява до 70% от времето на служителите. Ефективното използване на AI за получаване на информация играе огромна роля тук!

Как ClickUp използва усъвършенствани AI техники

Изборът между RAG и фино настройване е доста голям дебат.

Дори прегледането на няколко теми в Reddit е достатъчно, за да ви обърка. Но кой е казал, че трябва да изберете само едно?

Представете си, че имате персонализирани AI модели, автоматизация и управление на задачите на едно място. Това е ClickUp, приложението за всичко, свързано с работата. То обединява управлението на проекти, документацията и комуникацията в екипа под един покрив и се захранва от AI от ново поколение.

Накратко, той се отличава във всичко, особено с цялостното си AI решение: ClickUp Brain.

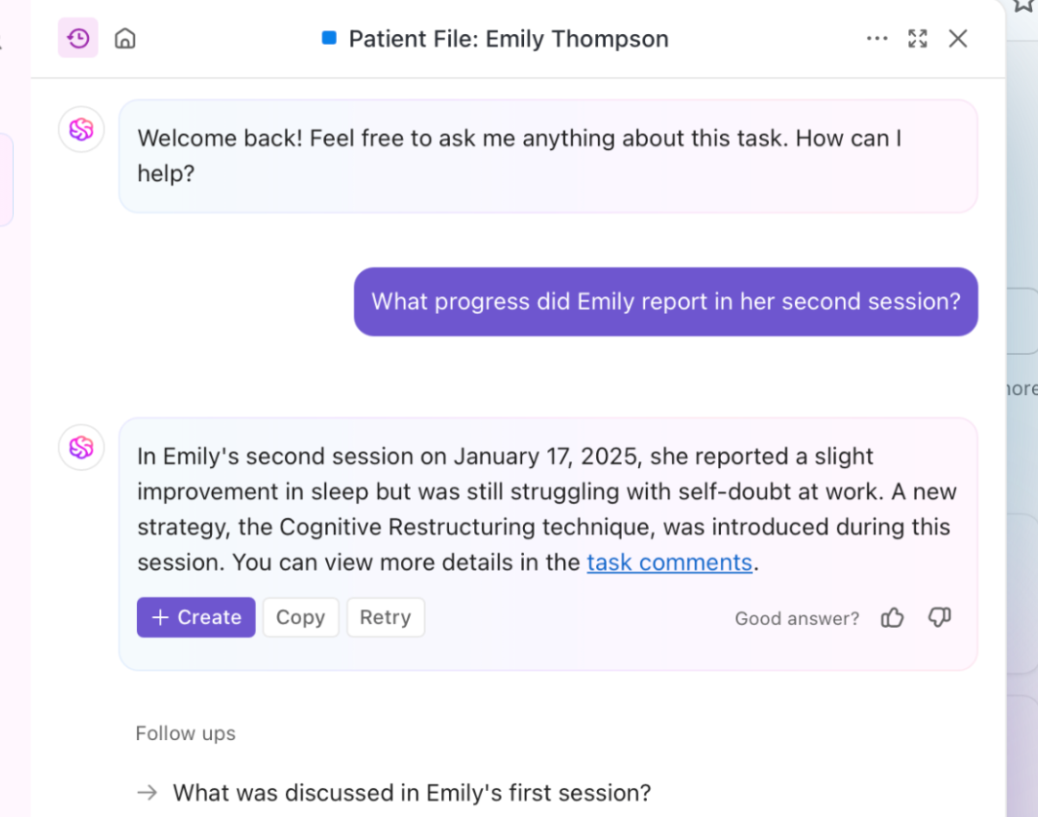

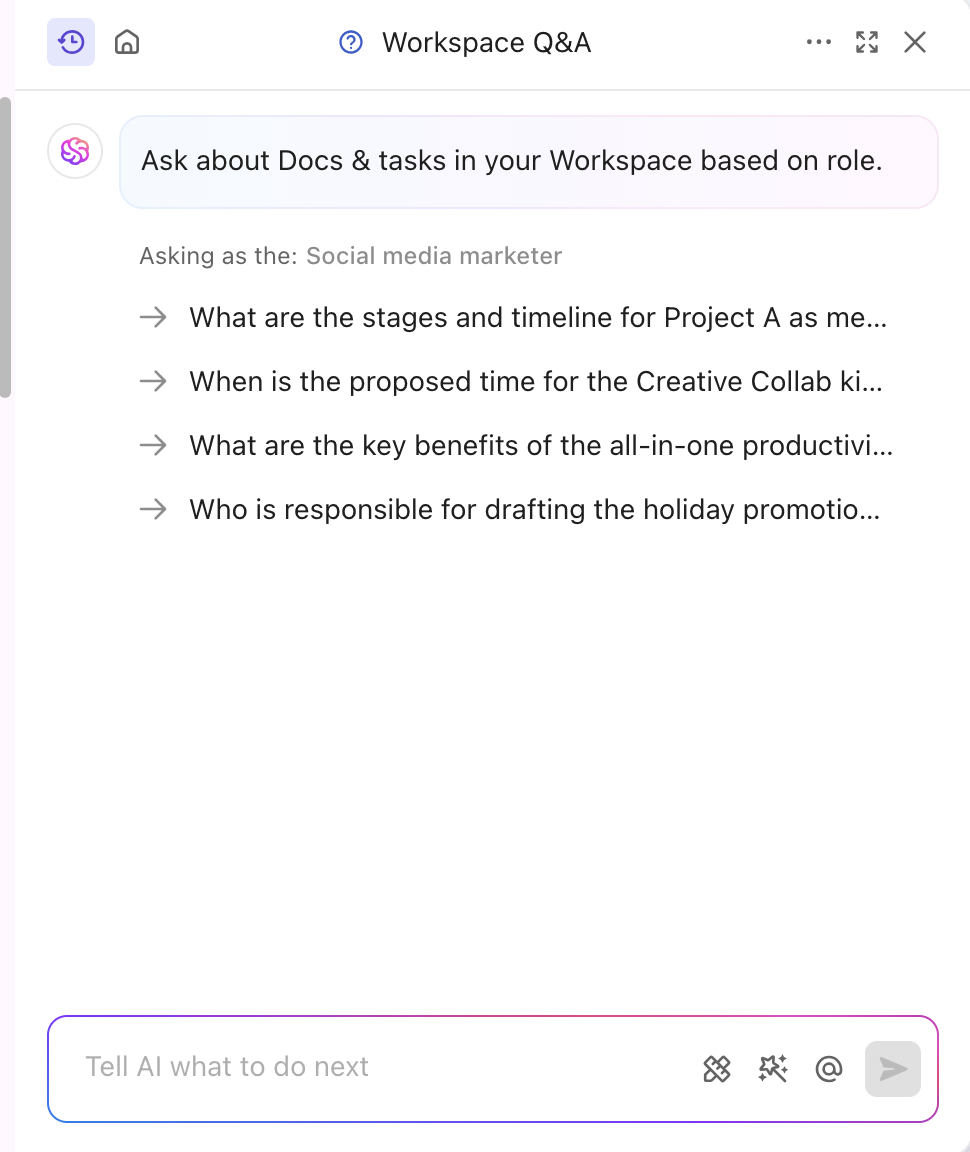

Имате нужда от бързи, контекстно-ориентирани прозрения? Brain извлича информация в реално време от вашите документи, задачи и ресурси. Това е усъвършенстваният RAG в действие. В допълнение към това, неговият основен LLM, Brain, може да генерира отчети и рутинни актуализации на проекти.

AI инструментът е фино настроен, за да съответства на вашата индустрия и сегмент, като предоставя професионални и креативни идеи. Той дори персонализира съдържанието в реално време без никакво ръчно обучение. Brain съчетава фино настройване и RAG, за да автоматизира актуализациите на проекти, задачите и уведомленията за работния процес. Искате отговори, които са съобразени с вашата роля? ClickUp Brain може да направи и това!

Освен че е специализирана в съдържанието, платформата ClickUp разполага и с мощна AI функция, базирана на знания.

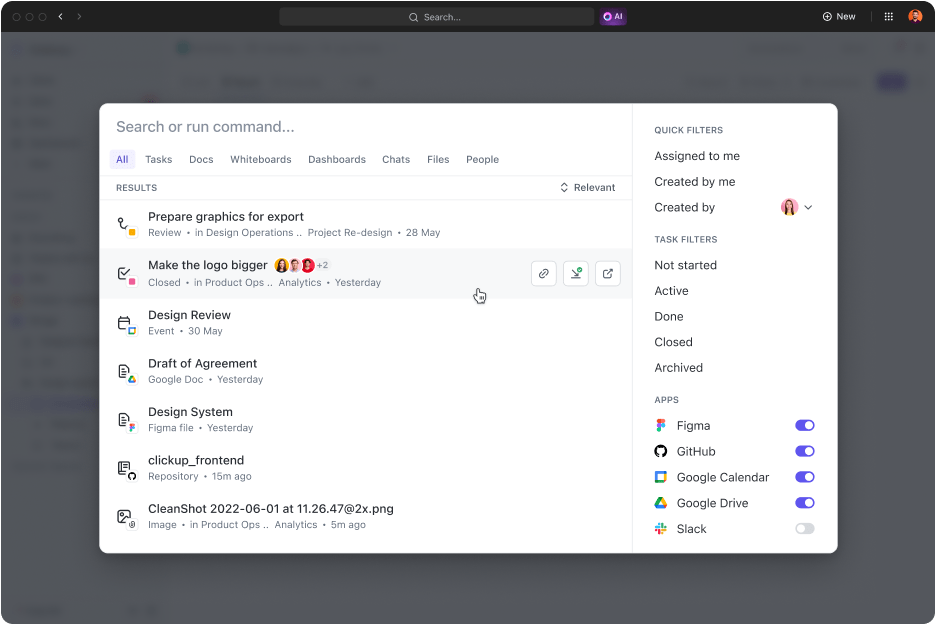

ClickUp Connected Search е инструмент, задвижван от изкуствен интелект, който бързо извлича всеки ресурс от вашето интегрирано пространство. Независимо дали се нуждаете от документи за днешната среща или отговори на някаква задача, едно просто запитване извежда източници, цитати и подробна информация.

Той също така стартира приложения, търси в историята на клипборда ви и създава фрагменти. А най-хубавото? Всичко това е достъпно с едно кликване от командния център, лентата с действия или десктопа ви.

Експертите по дигитален маркетинг, дори президентът на Hum JAM, казват, че

ClickUp е най-невероятният „всичко в едно” инструмент за автоматизация на екипа, който проследява, автоматизира и измерва успеха на екипа. Повярвайте ми, когато казвам, че вашият екип не може да живее без този инструмент.

ClickUp е най-невероятният „все в едно” инструмент за автоматизация на екипа, който проследява, автоматизира и измерва успеха на екипа. Повярвайте ми, когато казвам, че вашият екип не може да живее без този инструмент.

➡️ Прочетете също: Разликата между машинно обучение и изкуствен интелект

Повишаване на точността на Gen AI и LLM с ClickUp

Отговорите на RAG, усъвършенствани чрез нови външни данни и фино настройване, се използват за конкретни задачи и поведения. И двете подобряват производителността на AI, но правилният подход определя вашия темп и ефективност.

В динамичните индустрии решението често се свежда до това, кой метод да се приложи първо. Мощно предварително обучено решение обикновено е по-разумният избор.

Ако искате да подобрите качеството на обслужването и производителността, ClickUp е чудесен партньор. Неговите AI възможности стимулират генерирането на съдържание, извличането на данни и аналитичните отговори. Освен това платформата разполага с над 30 инструмента, които обхващат всичко – от управление на задачи до генериране на впечатляващи визуализации.

Регистрирайте се в ClickUp още днес!