Mô hình AI của bạn đã bao giờ đưa ra câu trả lời chắc chắn nhưng người dùng lại cho là lỗi thời chưa? Đó là loại trải nghiệm khiến nhóm của bạn nghi ngờ mọi phản hồi của mô hình.

Điều này nghe có vẻ như cơn ác mộng của mọi nhà phát triển và người đam mê AI, phải không?

Các mô hình ngôn ngữ lớn (LLMs) hoạt động dựa trên dữ liệu đào tạo, nhưng khi dữ liệu trở nên lỗi thời, sai sót bắt đầu xuất hiện. Vì việc đào tạo lại tốn hàng triệu đô la, tối ưu hóa là giải pháp thông minh hơn.

Retrieval Augmented Generation (RAG) và tinh chỉnh là hai khung công tác hàng đầu để tăng độ chính xác. Tuy nhiên, do sự khác biệt giữa mỗi phương pháp, chúng lý tưởng cho các ứng dụng khác nhau. Khung công tác phù hợp là khóa để cải thiện LLM của bạn một cách hiệu quả.

Nhưng phương pháp nào phù hợp với bạn?

Bài viết này giải quyết vấn đề nan giải trong hướng dẫn RAG và Fine-Tuning. Cho dù bạn đang làm việc với dữ liệu chuyên ngành hay muốn xây dựng các giải pháp truy xuất dữ liệu chất lượng cao, bạn sẽ tìm thấy câu trả lời tại đây!

⏰Tóm tắt 60 giây

- Cải thiện hiệu suất của LLM và mô hình AI là một phần quan trọng trong mọi hoạt động kinh doanh và phát triển. Mặc dù RAG và tinh chỉnh là hai phương pháp phổ biến, nhưng điều quan trọng là phải hiểu rõ sự khác biệt và tác động của chúng

- RAG trang bị cho LLM khả năng truy xuất dữ liệu thời gian thực từ nguồn bên ngoài, giúp giảm chi phí đào tạo lại

- Fine-tuning tối ưu hóa LLM bằng cách đào tạo trên các tập dữ liệu chuyên biệt, cải thiện độ chính xác cho các công việc cụ thể trong lĩnh vực

- RAG là lựa chọn tốt nhất cho các môi trường dữ liệu thay đổi nhanh như tài chính, cập nhật pháp lý và hỗ trợ khách hàng

- Fine-tuning là lựa chọn lý tưởng cho AI chuyên biệt cho thương hiệu, các ngành có yêu cầu tuân thủ cao và phân tích cảm xúc

- ClickUp Brain kết hợp cả hai, sử dụng RAG để cung cấp thông tin chi tiết theo ngữ cảnh và tinh chỉnh để tự động hóa và tạo nội dung phù hợp

- Các công cụ hỗ trợ AI của ClickUp tăng cường khả năng truy xuất kiến thức, tự động hóa quy trình làm việc và quản lý dự án để đạt hiệu quả cao nhất

Retrieval-Augmented Generation (RAG) là gì?

Bạn đang xem các báo cáo và khảo sát mới mà mô hình LLM của bạn đã bỏ qua? Đó chính là lúc bạn cần đến RAG. Để hiểu rõ hơn về phương pháp này, hãy cùng tìm hiểu những kiến thức cơ bản.

Định nghĩa về RAG

RAG là một khung công nghệ AI sử dụng việc thu thập thông tin bổ sung cho mô hình ngôn ngữ lớn (LLM) để nâng cao độ chính xác của phản hồi. Trước khi tạo ra phản hồi, RAG sẽ trích xuất dữ liệu liên quan nhất từ các nguồn bên ngoài, chẳng hạn như cơ sở kiến thức hoặc cơ sở dữ liệu.

Hãy xem nó như một trợ lý nghiên cứu bên trong mô hình LLM hoặc mô hình AI tạo sinh.

👀 Bạn có biết? LLM, đặc biệt là trình tạo văn bản, có thể tạo ra ảo giác bằng cách tạo ra thông tin sai nhưng có vẻ hợp lý. Tất cả là do lỗ hổng trong dữ liệu đào tạo.

Các lợi thế chính của RAG

Có lẽ đến giờ thì mọi thứ đã rõ ràng. RAG là một lớp AI kết nối bổ sung mà quy trình kinh doanh của bạn cần. Để làm nổi bật tiềm năng của nó, đây là những lợi thế mà nó mang lại:

- Giảm chi phí đào tạo: Loại bỏ nhu cầu đào tạo lại mô hình thường xuyên nhờ khả năng truy xuất thông tin động. Điều này giúp triển khai AI hiệu quả về chi phí, đặc biệt trong các lĩnh vực có dữ liệu thay đổi nhanh chóng

- Khả năng mở rộng: Mở rộng kiến thức của LLM mà không làm tăng kích thước hệ thống chính. Chúng giúp các doanh nghiệp mở rộng quy mô, quản lý các tập dữ liệu lớn và chạy nhiều truy vấn hơn mà không tốn chi phí tính toán cao

- Cập nhật thời gian thực: Phản ánh thông tin mới nhất trong mỗi phản hồi và giữ cho mô hình luôn cập nhật. Việc ưu tiên độ chính xác thông qua cập nhật thời gian thực là vô cùng quan trọng trong nhiều hoạt động, bao gồm phân tích tài chính, y tế và kiểm toán tuân thủ

📮 ClickUp Insight: Một nửa số người được hỏi gặp khó khăn trong việc áp dụng AI; 23% không biết bắt đầu từ đâu, trong khi 27% cần thêm đào tạo để thực hiện các tác vụ nâng cao.

ClickUp giải quyết vấn đề này bằng giao diện trò chuyện quen thuộc, giống như nhắn tin văn bản. Các nhóm có thể tham gia ngay với các câu hỏi và yêu cầu đơn giản, sau đó tự nhiên khám phá các tính năng tự động hóa và quy trình làm việc mạnh mẽ hơn trong quá trình sử dụng mà không cần phải trải qua quá trình học tập khó khăn khiến nhiều người nản lòng.

Các trường hợp sử dụng RAG

Bạn đang tự hỏi RAG có ưu điểm gì? Hãy xem xét các trường hợp sử dụng khóa sau:

Chatbot và hỗ trợ khách hàng

Các truy vấn của khách hàng thường yêu cầu phản hồi cập nhật và phù hợp với ngữ cảnh. RAG tăng cường khả năng của chatbot bằng cách truy xuất các bài viết hỗ trợ, chính sách và các bước khắc phục sự cố mới nhất.

Điều này cho phép hỗ trợ chính xác hơn, theo thời gian thực mà không cần đào tạo trước nhiều.

Truy xuất tài liệu động

RAG tối ưu hóa tìm kiếm tài liệu bằng cách trích xuất các phần có liên quan nhất từ kho lưu trữ khổng lồ. Thay vì tóm tắt chung chung, LLM có thể cung cấp câu trả lời chính xác từ các hướng dẫn cập nhật, bài nghiên cứu hoặc tài liệu pháp lý.

Sử dụng các mô hình ngôn ngữ lớn (LLM) được hỗ trợ bởi RAG giúp việc truy xuất thông tin nhanh chóng và chính xác hơn.

🧠 Thông tin thú vị: Meta, công ty sở hữu Facebook, Instagram, Threads và WhatsApp, đã giới thiệu RAG vào phát triển LLM vào năm 2020.

Fine-Tuning là gì?

Hãy cùng tìm hiểu việc tinh chỉnh có tác dụng gì.

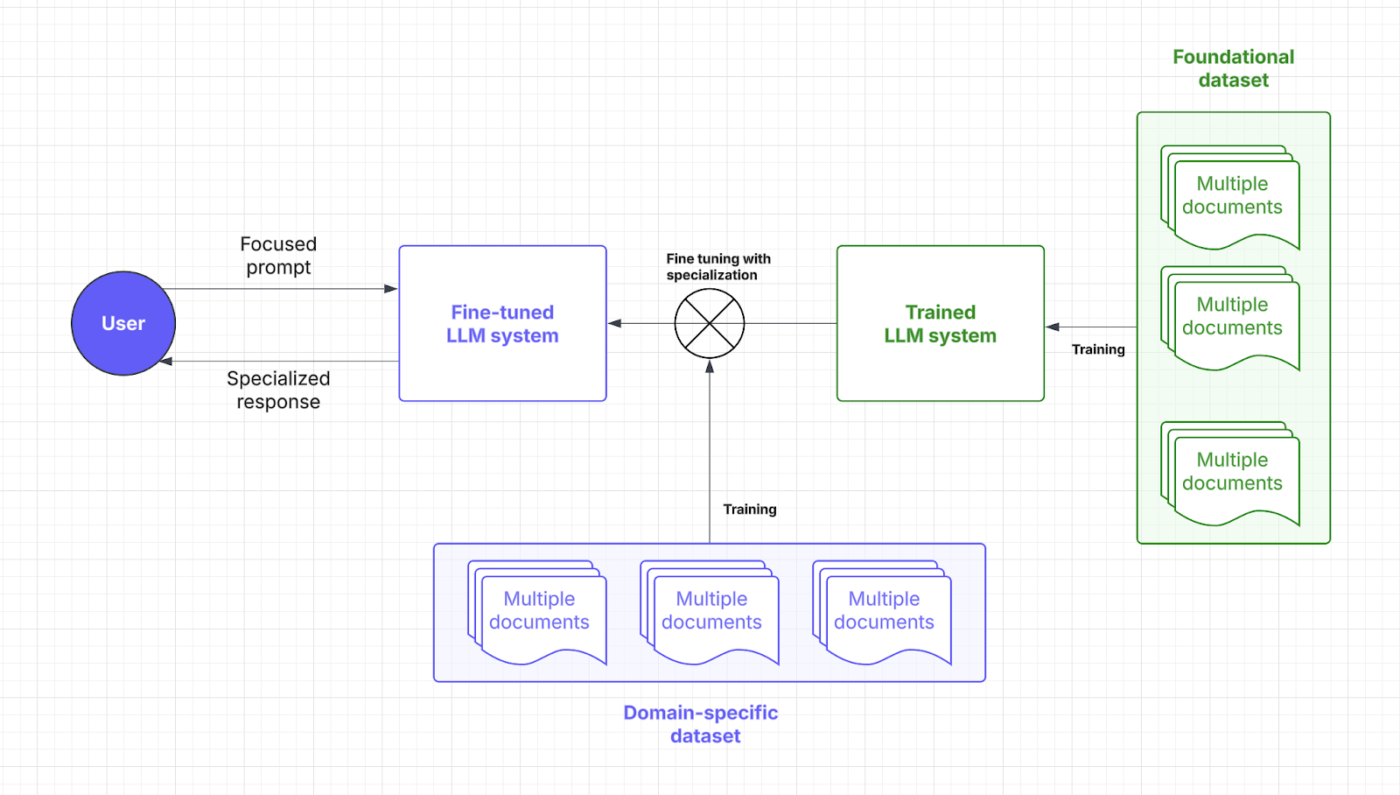

Định nghĩa về Fine-Tuning

Fine-tuning là quá trình đào tạo lại một mô hình ngôn ngữ đã được đào tạo sẵn. Đúng vậy, quá trình này đòi hỏi nhiều thời gian đào tạo, và có thể được giải thích thông qua việc tập trung vào các điểm cụ thể.

🧠 Bạn có biết: Trong đào tạo Mô hình ngôn ngữ lớn (LLM), "trọng số" là các tham số có thể điều chỉnh trong mạng nơ-ron, quyết định sức mạnh của các kết nối giữa các nơ-ron, về cơ bản là lưu trữ thông tin đã học; quá trình đào tạo tối ưu hóa các trọng số này để giảm thiểu lỗi dự đoán.

mặt khác, "Tập trung" bao gồm một số khía cạnh: bao gồm việc quản lý dữ liệu cẩn thận để đảm bảo chất lượng và tính liên quan, sử dụng các cơ chế chú ý để ưu tiên các phân đoạn đầu vào có liên quan và tinh chỉnh có mục tiêu để chuyên biệt hóa mô hình cho các công việc cụ thể.

Thông qua các bộ dữ liệu chuyên biệt, tinh chỉnh cho phép các mô hình AI thu hẹp phạm vi thực thi các công việc cụ thể trong lĩnh vực. Bằng cách điều chỉnh trọng số và trọng tâm của mô hình, LLM của bạn sẽ có được sự hiểu biết về ngữ cảnh và độ chính xác cao hơn.

Hãy xem Fine-Tuning như là bằng thạc sĩ mà LLM của bạn cần để nói ngôn ngữ của ngành của bạn. Hãy cùng xem xét vị trí mà chiến lược AI này được áp dụng trong quá trình phản hồi prompt:

Lợi ích của Fine-Tuning

Các kỹ thuật Fine-Tuning chỉ là những điều chỉnh nhỏ trong AI. Nó giống như khả năng phóng to các chi tiết đã được định sẵn. Dưới đây là những lợi ích mà nó mang lại:

- Tối ưu hóa cho công việc cụ thể: Bộ dữ liệu chuyên biệt giúp cải thiện phản hồi LLM cho các công việc cụ thể. Bạn muốn giúp người dùng tránh khỏi những câu hỏi phức tạp? Fine-tuning giúp các nhà phát triển có được các giải pháp AI phù hợp

- Cải thiện độ chính xác cho các ứng dụng chuyên biệt: Kiến thức về lĩnh vực giúp giảm lỗi và nâng cao độ chính xác của mỗi phản hồi. Fine-Tuning cũng tăng độ tin cậy của LLM, giúp doanh nghiệp không phải lo lắng về việc quản lý chi tiết và giám sát thủ công

- Tùy chỉnh cho giọng điệu thương hiệu và tuân thủ: Fine-tuning dạy LLM các thuật ngữ, phong cách và quy định của công ty. Điều này giúp duy trì giọng điệu thương hiệu nhất quán và tuân thủ các quy định cụ thể của ngành

Các trường hợp sử dụng Fine-Tuning

Quá trình tinh chỉnh của bạn sẽ mở ra hiệu quả mục tiêu. Dưới đây là những điểm nổi bật của nó:

Hệ thống QA chuyên ngành

Các ngành như pháp lý, y tế và tài chính phụ thuộc vào các phản hồi AI chính xác và am hiểu lĩnh vực. Fine-tuning trang bị cho LLMs kiến thức chuyên môn, đảm bảo khả năng trả lời câu hỏi (QA) chính xác.

Ví dụ, một trợ lý AI pháp lý có thể giải thích hợp đồng chính xác hơn, trong khi chatbot y tế có thể cung cấp hướng dẫn dựa trên triệu chứng bằng cách sử dụng bộ dữ liệu đáng tin cậy.

Phân tích cảm xúc và quy trình công việc tùy chỉnh

Các doanh nghiệp sử dụng mô hình tinh chỉnh để giám sát thương hiệu, phân tích phản hồi của khách hàng và tự động hóa quy trình làm việc phù hợp với nhu cầu hoạt động riêng biệt. Công cụ hỗ trợ AI có thể phát hiện những cảm xúc tinh tế trong các đánh giá sản phẩm, giúp các công ty cải thiện sản phẩm của mình.

Trong lĩnh vực Nhân sự (HR), việc kết hợp tinh chỉnh (Fine-Tuning) với xử lý ngôn ngữ tự nhiên (NLP) giúp AI phân tích các cuộc khảo sát nhân viên và phát hiện các vấn đề tại nơi làm việc với sự hiểu biết ngữ cảnh sâu sắc hơn.

💡 Mẹo chuyên nghiệp: Fine-tuning có thể bao gồm việc thêm dữ liệu đa dạng hơn để loại bỏ các thành kiến tiềm ẩn. Mặc dù không hoàn toàn chuyên biệt cho lĩnh vực cụ thể, nhưng đây vẫn là một ứng dụng quan trọng.

So sánh: RAG vs. Fine-Tuning

Không thể phủ nhận rằng cả hai chiến lược AI đều nhằm mục đích nâng cao hiệu suất.

Nhưng việc lựa chọn vẫn còn khá phức tạp, phải không? Dưới đây là phân tích chi tiết về Fine-Tuning và RAG để giúp bạn đưa ra quyết định đúng đắn cho đầu tư vào LLM của mình.

| Aspect | RAG (Retrieval-augmented generation) | Fine-tuning |

| Định nghĩa | Cho phép LLM truy xuất dữ liệu thời gian thực, liên quan từ các nguồn bên ngoài thông qua hệ thống chuyên dụng của nó | Huấn luyện mô hình được huấn luyện sẵn với bộ dữ liệu chuyên biệt cho các công việc cụ thể trong lĩnh vực |

| Hiệu suất và độ chính xác | Tuyệt vời cho việc truy xuất dữ liệu thời gian thực, nhưng độ chính xác phụ thuộc vào chất lượng dữ liệu bên ngoài | Cải thiện độ chính xác theo ngữ cảnh và phản hồi phù hợp với công việc cụ thể |

| Yêu cầu về chi phí và tài nguyên | Tập trung vào việc truy cập dữ liệu thời gian thực với chi phí ban đầu thấp hơn | Yêu cầu nhiều tài nguyên hơn cho giai đoạn đào tạo ban đầu, nhưng hiệu quả về chi phí trong dài hạn |

| Bảo trì và khả năng mở rộng | Có khả năng mở rộng cao và linh hoạt, nhưng phụ thuộc vào tần suất cập nhật từ các nguồn bên ngoài | Yêu cầu cập nhật và bảo trì thường xuyên nhưng mang lại hiệu suất ổn định lâu dài |

| Trường hợp sử dụng | Chatbot, truy xuất tài liệu động, phân tích thời gian thực | Hệ thống QA dành riêng cho lĩnh vực, phân tích cảm xúc và tùy chỉnh giọng điệu thương hiệu |

| Khi nào nên chọn | Dữ liệu thay đổi nhanh chóng, cập nhật thời gian thực và ưu tiên chi phí tài nguyên | Phân khúc khách hàng ngách, logic riêng cho từng lĩnh vực, tùy chỉnh riêng cho từng thương hiệu |

| Phù hợp cho | Các ngành công nghiệp cần thông tin chính xác, thời gian thực (tài chính, pháp lý, hỗ trợ khách hàng) | Các ngành yêu cầu ngôn ngữ chuyên ngành, tuân thủ quy định hoặc bối cảnh cụ thể (y tế, pháp lý, nhân sự) |

Cần thêm thông tin để giải đáp thắc mắc? Dưới đây là so sánh trực tiếp các khía cạnh quan trọng ảnh hưởng đến nhu cầu của bạn.

Hiệu suất và độ chính xác

Khi nói đến hiệu suất, RAG đóng vai trò khóa bằng cách lấy dữ liệu mới từ các nguồn bên ngoài. Độ chính xác và thời gian phản hồi của nó phụ thuộc vào chất lượng dữ liệu này. Sự phụ thuộc vào cơ sở dữ liệu bên ngoài cho phép RAG cung cấp thông tin cập nhật một cách hiệu quả.

Fine-tuning, mặt khác, cải thiện cách mô hình xử lý và phản hồi thông qua quá trình đào tạo lại chuyên sâu. Quá trình này mang lại các phản hồi chính xác hơn về ngữ cảnh, đặc biệt là cho các ứng dụng chuyên biệt. Các mô hình LLM được fine-tuning là lựa chọn lý tưởng để duy trì tính nhất quán trong các ngành có yêu cầu nghiêm ngặt, như y tế hoặc tài chính.

Kết luận: RAG rất phù hợp cho dữ liệu thời gian thực và Fine-Tuning để đạt được phản hồi chính xác theo ngữ cảnh.

Một người dùng Reddit cho biết

Nếu bạn đang sử dụng mô hình nhỏ và cơ sở dữ liệu tốt trong quy trình RAG, bạn có thể tạo ra bộ dữ liệu chất lượng cao, tốt hơn so với việc sử dụng đầu ra từ mô hình AI chất lượng cao.

Nếu bạn đang sử dụng mô hình nhỏ và cơ sở dữ liệu tốt trong quy trình RAG, bạn có thể tạo ra bộ dữ liệu chất lượng cao, tốt hơn so với việc sử dụng đầu ra từ mô hình AI chất lượng cao.

💡 Mẹo chuyên nghiệp: Để hướng dẫn LLM đạt được kết quả cụ thể, hãy tập trung vào kỹ thuật tạo prompt hiệu quả.

Yêu cầu về chi phí và tài nguyên

RAG thường tiết kiệm chi phí hơn vì chỉ thêm một lớp để truy xuất dữ liệu bên ngoài. Bằng cách tránh phải đào tạo lại toàn bộ mô hình, RAG trở thành một lựa chọn tiết kiệm hơn, đặc biệt là trong môi trường động. Tuy nhiên, chi phí vận hành để truy cập và lưu trữ dữ liệu thời gian thực có thể tăng lên.

Fine-tuning đòi hỏi nhiều công sức chuẩn bị dữ liệu và tài nguyên đào tạo hơn, nhưng là một khoản đầu tư lâu dài. Sau khi được fine-tuning, các mô hình LLM cần ít cập nhật hơn, dẫn đến hiệu suất ổn định và tiết kiệm chi phí. Các nhà phát triển nên đánh giá kỹ lưỡng giữa chi phí ban đầu và chi phí vận hành liên tục.

Kết luận: RAG có chi phí thấp, dễ triển khai và mang lại lợi ích nhanh chóng. Fine-tuning đòi hỏi nhiều tài nguyên ban đầu nhưng cải thiện chất lượng LLM và tiết kiệm chi phí vận hành trong dài hạn.

💡 Mẹo chuyên nghiệp: Hệ thống RAG của bạn chỉ thông minh như dữ liệu mà nó thu thập. Hãy đảm bảo nguồn dữ liệu của bạn sạch sẽ và chứa dữ liệu chính xác, cập nhật!

Bảo trì và khả năng mở rộng

RAG cung cấp khả năng mở rộng tuyệt vời vì tập trung chủ yếu vào việc mở rộng nguồn bên ngoài. Tính linh hoạt và khả năng thích ứng của nó làm cho nó trở nên hoàn hảo cho các ngành công nghiệp phát triển nhanh. Tuy nhiên, việc bảo trì phụ thuộc vào tần suất cập nhật cơ sở dữ liệu bên ngoài.

Fine-tuning cần bảo trì khá thường xuyên, đặc biệt là khi thông tin cụ thể về lĩnh vực thay đổi. Mặc dù đòi hỏi nhiều tài nguyên hơn, nhưng phương pháp này mang lại tính nhất quán cao hơn theo thời gian và dần dần cần ít điều chỉnh hơn. Tuy nhiên, khả năng mở rộng của fine-tuning phức tạp hơn nhiều, liên quan đến các tập dữ liệu rộng hơn và đa dạng hơn.

Kết luận: RAG là lựa chọn tốt nhất cho việc mở rộng quy mô nhanh chóng và tinh chỉnh để đạt được hiệu suất ổn định với chi phí bảo trì tối thiểu.

Một người dùng Reddit bổ sung thêm

Khi công việc nhỏ, thường sẽ hiệu quả hơn nếu sử dụng mô hình lớn hơn thay vì tinh chỉnh mô hình nhỏ hơn.

Khi công việc nhỏ, thường sẽ hiệu quả hơn nếu sử dụng mô hình lớn hơn thay vì tinh chỉnh mô hình nhỏ hơn.

👀 Bạn có biết? Hiện nay có những giải pháp AI có thể ngửi được mùi. Với sự phức tạp của các loại hương thơm, điều này đòi hỏi rất nhiều việc tinh chỉnh thường xuyên và truy xuất dữ liệu phức tạp.

Phương pháp nào phù hợp với trường hợp sử dụng của bạn?

Mặc dù hiểu được các sắc thái, việc đưa ra quyết định có thể cảm thấy trống rỗng nếu không có tham chiếu hoặc bối cảnh rõ ràng. Hãy chạy một vài kịch bản kinh doanh để nêu bật cách mỗi mô hình AI hoạt động tốt hơn.

Khi nào nên chọn RAG

RAG giúp cung cấp cho LLM của bạn các dữ liệu và thông tin chính xác, bao gồm các tiêu chuẩn kỹ thuật, hồ sơ bán hàng, phản hồi của khách hàng và hơn thế nữa.

Làm thế nào để áp dụng điều này? Hãy xem xét các tình huống sau để áp dụng RAG vào hoạt động của bạn:

Trường hợp sử dụng #1: Phân tích thời gian thực

- Tình huống: Một công ty fintech cung cấp thông tin thị trường dựa trên AI cho các nhà giao dịch. Người dùng hỏi về xu hướng cổ phiếu và hệ thống phải lấy các báo cáo thị trường, hồ sơ SEC và tin tức mới nhất

- Tại sao RAG thắng: Thị trường chứng khoán thay đổi nhanh chóng, do đó việc liên tục đào tạo lại mô hình AI là tốn kém và kém hiệu quả. RAG duy trì độ chính xác bằng cách chỉ lấy dữ liệu tài chính mới nhất, giảm chi phí và nâng cao độ chính xác

- Quy tắc chung: RAG nên là chiến lược ưu tiên của bạn khi AI xử lý dữ liệu thay đổi nhanh. Các ứng dụng phổ biến là phân tích dữ liệu mạng xã hội, tối ưu hóa năng lượng, phát hiện mối đe dọa an ninh mạng và theo dõi đơn đặt hàng

Trường hợp sử dụng #2: Kiểm tra dữ liệu và tuân thủ quy định

- Tình huống: Một trợ lý AI pháp lý hỗ trợ luật sư soạn thảo hợp đồng và kiểm tra tuân thủ các quy định pháp luật đang thay đổi bằng cách tra cứu các văn bản pháp luật mới nhất, tiền lệ và phán quyết

- Tại sao RAG lại chiến thắng: Việc xác minh các khía cạnh pháp lý và thương mại không đòi hỏi cập nhật hành vi sâu sắc. RAG thực hiện công việc này khá tốt bằng cách lấy văn bản pháp lý từ bộ dữ liệu trung tâm theo thời gian thực

- Quy tắc chung: RAG vượt trội trong việc cung cấp thông tin chi tiết dựa trên tài nguyên và thống kê. Cách tốt nhất để tối đa hóa hiệu quả là sử dụng trợ lý AI y tế để đưa ra khuyến nghị điều trị và chatbot khách hàng để khắc phục sự cố và cập nhật chính sách

Vẫn còn băn khoăn liệu có cần RAG trong mô hình LLM của bạn? Dưới đây là danh sách kiểm tra nhanh:

- Bạn có cần dữ liệu mới, chất lượng cao mà không thay đổi LLM không?

- Thông tin của bạn có thay đổi thường xuyên không?

- LLM của bạn có cần phải làm việc với thông tin động thay vì dữ liệu đào tạo tĩnh không?

- Bạn có muốn tránh chi phí lớn và quá trình đào tạo lại mô hình tốn thời gian không?

Khi Fine-tuning hiệu quả hơn

Như chúng tôi đã đề cập trước đó, tinh chỉnh là cấp học cao hơn của AI. LLM của bạn thậm chí có thể học thuật ngữ ngành. Dưới đây là những điểm nổi bật trong ngành về thời điểm nó thực sự phát huy tác dụng:

Trường hợp sử dụng #1: Thêm giọng điệu và phong cách thương hiệu

- Tình huống: Một thương hiệu cao cấp tạo ra một trợ lý AI để tương tác với khách hàng bằng giọng điệu tinh tế, độc đáo. Trợ lý này phải thể hiện được giọng điệu, cách diễn đạt và sắc thái cảm xúc đặc trưng của thương hiệu

- Tại sao Fine-Tuning lại hiệu quả: Fine-Tuning giúp mô hình AI nắm bắt và tái tạo giọng điệu và phong cách độc đáo của thương hiệu. Nó mang lại trải nghiệm nhất quán trong mọi tương tác

- Nguyên tắc chung: Fine-tuning hiệu quả hơn nếu mô hình ngôn ngữ lớn (LLM) của bạn cần thích ứng với một lĩnh vực chuyên môn cụ thể. Điều này lý tưởng cho các trò chơi nhập vai theo thể loại, kể chuyện có chủ đề và giàu cảm xúc, hoặc thậm chí là nội dung tiếp thị thương hiệu

🧠 Thông tin thú vị: LLM được đào tạo về các kỹ năng mềm này rất xuất sắc trong việc phân tích cảm xúc và mức độ hài lòng của nhân viên. Tuy nhiên, hiện chỉ có 3% doanh nghiệp sử dụng AI tạo ra nội dung trong lĩnh vực nhân sự.

Trường hợp sử dụng #2: Kiểm duyệt nội dung và thông tin chi tiết dựa trên ngữ cảnh

- Tình huống: Một nền tảng mạng xã hội sử dụng mô hình AI để phát hiện nội dung có hại. Mô hình này tập trung vào việc nhận dạng ngôn ngữ đặc trưng của nền tảng, tiếng lóng mới xuất hiện và các vi phạm liên quan đến ngữ cảnh

- Tại sao tinh chỉnh lại thắng: Các kỹ năng mềm như cách diễn đạt câu thường nằm ngoài phạm vi của hệ thống RAG. Tinh chỉnh giúp cải thiện khả năng hiểu của LLM về các sắc thái riêng của nền tảng và thuật ngữ ngành, đặc biệt là nội dung có liên quan đến kiểm duyệt

- Nguyên tắc chung: Chọn Fine-Tuning là lựa chọn khôn ngoan khi đối phó với sự khác biệt văn hóa hoặc khu vực. Điều này cũng áp dụng cho việc thích ứng với thuật ngữ chuyên ngành như y tế, pháp lý hoặc kỹ thuật

Bạn sắp tinh chỉnh LLM của mình? Hãy tự hỏi mình những câu hỏi quan trọng sau:

- LLM của bạn có cần cung cấp cho một phân khúc khách hàng hoặc chủ đề thương hiệu cụ thể không?

- Bạn có muốn thêm dữ liệu độc quyền hoặc dữ liệu chuyên ngành vào logic của LLM không?

- Bạn có cần phản hồi nhanh hơn mà không làm mất độ chính xác?

- Các mô hình ngôn ngữ lớn (LLM) của bạn có cung cấp giải pháp offline không?

- Bạn có thể phân bổ tài nguyên và sức mạnh tính toán chuyên dụng cho việc huấn luyện lại không?

Cải thiện trải nghiệm người dùng là điều tuyệt vời. Tuy nhiên, nhiều doanh nghiệp cũng cần AI để tăng năng suất nhằm biện minh cho chi phí đầu tư cao. Đó là lý do tại sao việc áp dụng mô hình AI được huấn luyện sẵn thường là lựa chọn hàng đầu của nhiều người.

👀 Bạn có biết? Gen AI có tiềm năng tự động hóa các hoạt động công việc, giúp tiết kiệm tới 70% thời gian của nhân viên. Việc yêu cầu AI cung cấp thông tin chi tiết một cách hiệu quả đóng vai trò rất lớn trong việc này!

Cách ClickUp tận dụng các kỹ thuật AI tiên tiến

Việc lựa chọn giữa RAG và Fine-Tuning là một vấn đề gây tranh cãi lớn.

Ngay cả việc xem qua một vài chủ đề trên Reddit cũng đủ khiến bạn bối rối. Nhưng ai nói rằng bạn chỉ cần chọn một trong số đó?

Hãy tưởng tượng bạn có các mô hình AI có thể tùy chỉnh, tự động hóa và quản lý công việc, tất cả ở một nơi. Đó là ClickUp, ứng dụng cho mọi công việc. Ứng dụng này kết hợp quản lý dự án, tài liệu và giao tiếp nhóm trong một nền tảng duy nhất và được hỗ trợ bởi AI thế hệ mới.

Tóm lại, nó xuất sắc trong mọi lĩnh vực, đặc biệt là với giải pháp AI toàn diện: ClickUp Brain.

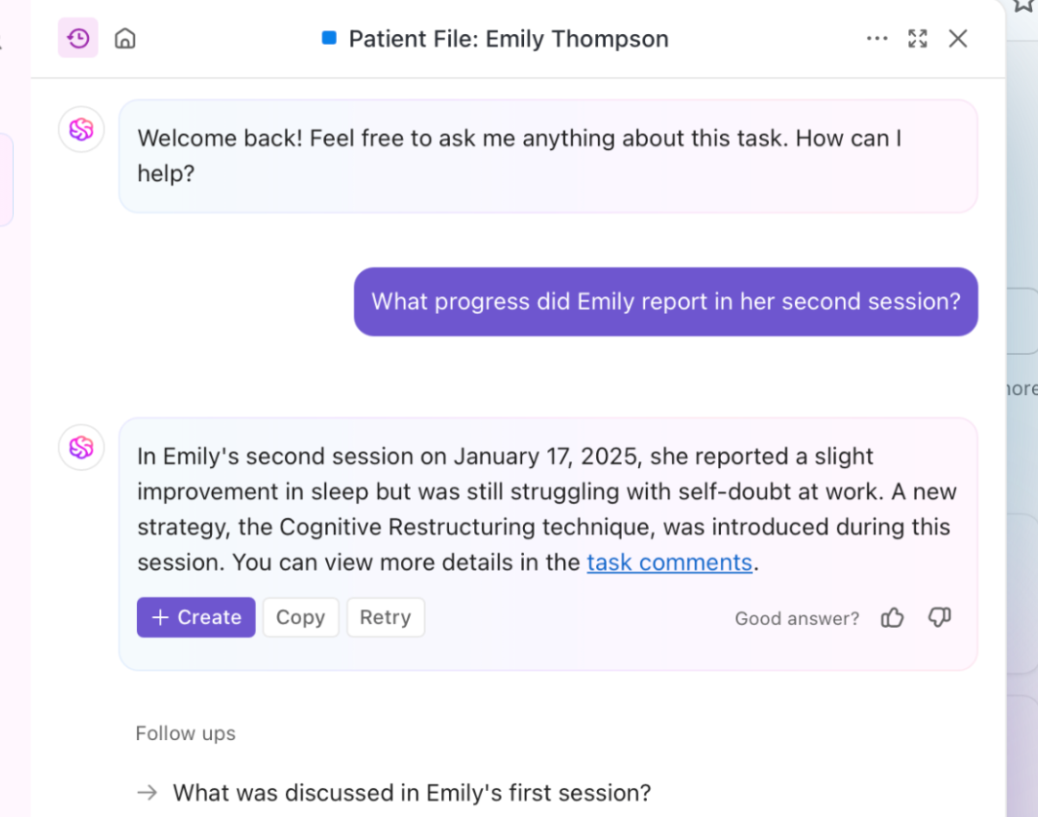

Cần thông tin chi tiết nhanh chóng, phù hợp với ngữ cảnh? Brain lấy thông tin thời gian thực từ tài liệu, công việc và tài nguyên của bạn. Đó là RAG được nâng cấp trong thực tế. Hơn nữa, LLM cơ bản của nó, Brain, có thể tạo báo cáo và cập nhật dự án thường xuyên.

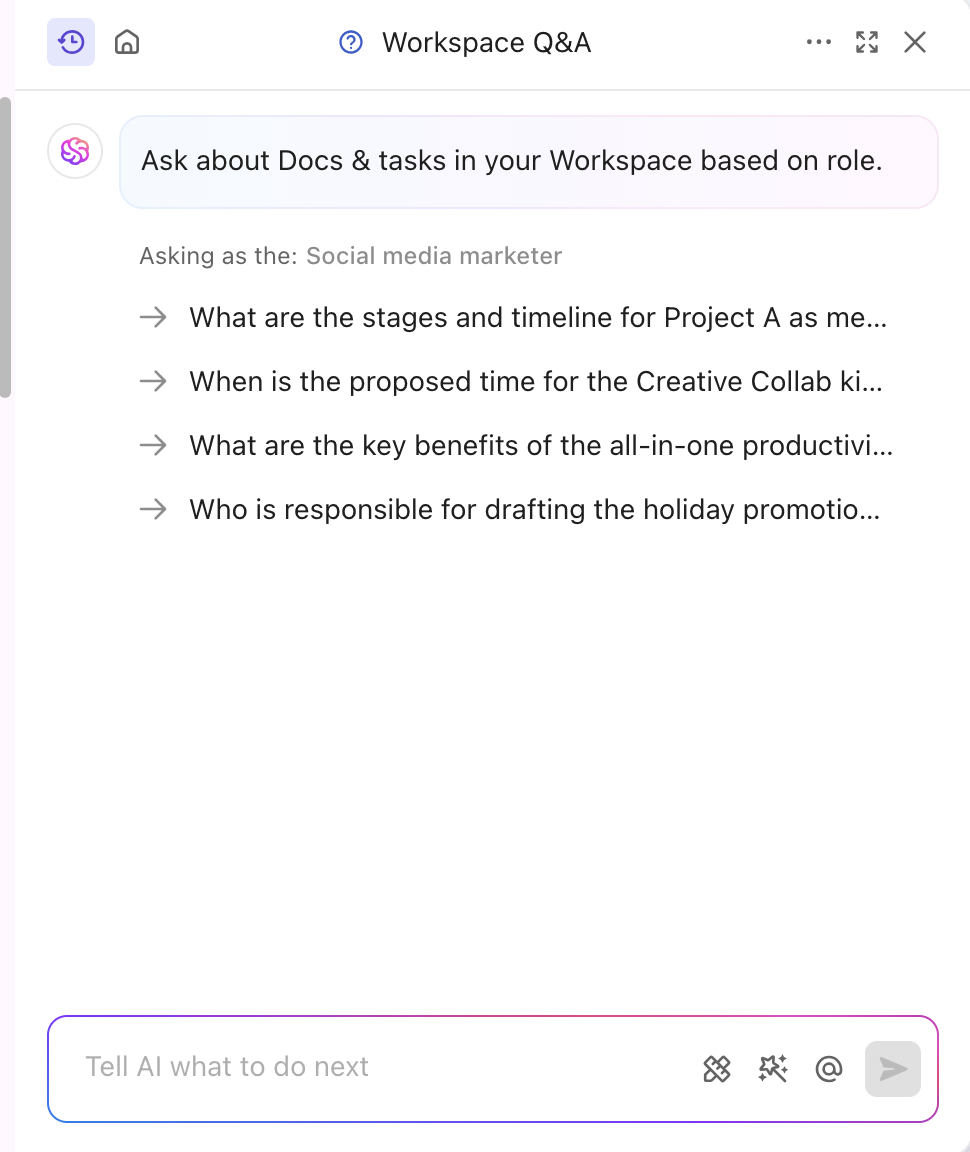

Công cụ AI cũng được tinh chỉnh để phù hợp với ngành và phân khúc của bạn, mang đến những thông tin chi tiết chuyên nghiệp và sáng tạo. Nó thậm chí còn cá nhân hóa nội dung theo thời gian thực mà không cần đào tạo thủ công. Brain kết hợp tinh chỉnh và RAG để tự động hóa cập nhật dự án, phân công nhiệm vụ và thông báo quy trình làm việc. Bạn muốn có những phản hồi phù hợp với vai trò của mình? ClickUp Brain cũng có thể làm điều đó!

Ngoài chuyên môn về nội dung, ClickUp còn trang bị cho nền tảng của mình tính năng AI dựa trên kiến thức mạnh mẽ.

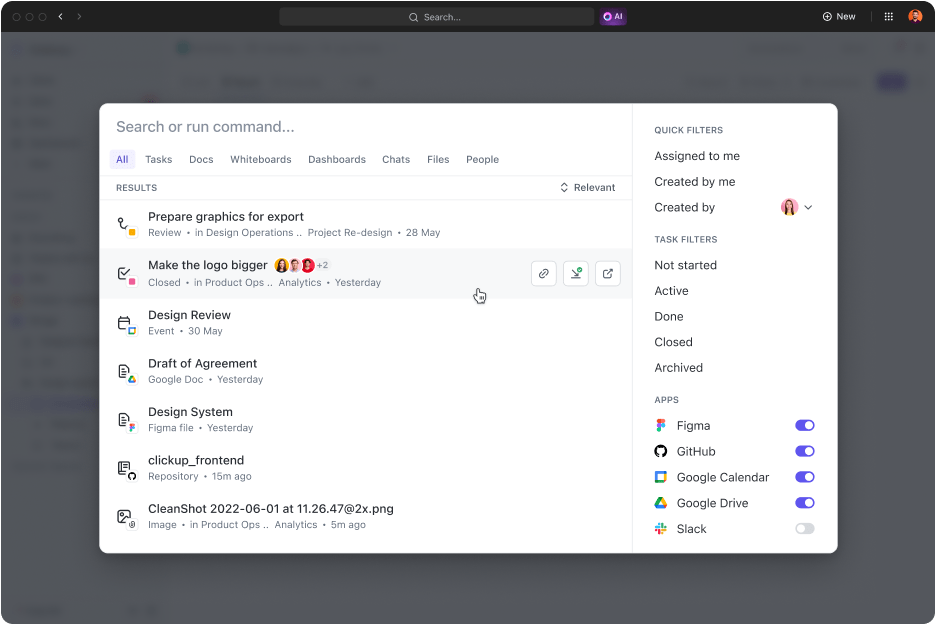

ClickUp Connected Search là một công cụ hỗ trợ AI giúp nhanh chóng truy xuất bất kỳ tài nguyên nào từ không gian tích hợp của bạn. Cho dù bạn cần tài liệu cho cuộc họp hàng ngày hay câu trả lời cho bất kỳ công việc nào, một truy vấn đơn giản sẽ hiển thị các liên kết nguồn, trích dẫn và thông tin chi tiết.

Nó cũng khởi chạy ứng dụng, tìm kiếm lịch sử clipboard và tạo đoạn trích. Phần hay nhất? Tất cả đều có thể truy cập bằng một cú nhấp chuột từ trung tâm điều khiển, thanh hành động hoặc máy tính để bàn của bạn.

Các chuyên gia tiếp thị kỹ thuật số, thậm chí Chủ tịch Hum JAM còn cho biết,

ClickUp là công cụ tự động hóa nhóm "tất cả trong một" tuyệt vời nhất, giúp theo dõi, tự động hóa và đo lường thành công của nhóm. Tin tôi đi, nhóm của bạn không thể thiếu công cụ này.

ClickUp là công cụ tự động hóa nhóm "tất cả trong một" tuyệt vời nhất, giúp theo dõi, tự động hóa và đo lường thành công của nhóm. Tin tôi đi, nhóm của bạn không thể thiếu công cụ này.

➡️ Xem thêm: Sự khác biệt giữa Học máy và Trí tuệ nhân tạo

Tăng cường Gen AI và độ chính xác LLM với ClickUp

Các phản hồi mạnh mẽ của RAG, được cải thiện nhờ dữ liệu bên ngoài mới và tinh chỉnh, được sử dụng cho các công việc và hành vi cụ thể. Cả hai đều cải thiện hiệu suất AI, nhưng phương pháp phù hợp sẽ quyết định tốc độ và hiệu quả của bạn.

Trong các ngành công nghiệp động, quyết định thường phụ thuộc vào việc chọn phương pháp nào để áp dụng trước tiên. Một giải pháp được đào tạo sẵn mạnh mẽ thường là lựa chọn khôn ngoan hơn.

Nếu bạn muốn cải thiện chất lượng dịch vụ và năng suất, ClickUp là một đối tác tuyệt vời. Khả năng AI của nó thúc đẩy việc tạo nội dung, truy xuất dữ liệu và phản hồi phân tích. Ngoài ra, nền tảng này còn đi kèm với hơn 30 công cụ bao gồm mọi thứ, từ quản lý công việc đến tạo hình ảnh ấn tượng.

Đăng ký ClickUp ngay hôm nay!