Vad är MCP?

MCP, eller Model Context Protocol, är en öppen källkodsstandard som gör det möjligt för alla kompatibla AI-modeller att begära data, funktioner eller uppmaningar från alla kompatibla servrar via ett delat JSON-RPC 2. 0-gränssnitt.

Genom att standardisera hur verktyg beskriver sina funktioner ersätter MCP skräddarsydda engångskontakter, vilket minskar integrationerna från exponentiell komplexitet (N×M) till linjär ansträngning (N+M).

Anthropic tillkännagav MCP i november 2024 som sin lösning för att bryta ner informationssilos som isolerar AI-modeller från verkliga data.

Istället för att bygga separata anslutningar för varje modell-till-verktygskombination skapar utvecklare nu en MCP-server som fungerar med Claude, GPT eller något annat kompatibelt AI-system.

VentureBeat jämförde det med en ”USB-C-port för AI”, som gör det möjligt för modeller att söka i databaser och interagera med CRM-system utan anpassade anslutningar.

Viktiga slutsatser

- MCP förenklar AI-integrationer genom att ersätta anpassade anslutningar med en gemensam standard.

- Det gör det möjligt för AI-agenter att få tillgång till realtidsdata, vilket minskar hallucinationer och gissningar.

- Organisationer rapporterar stora effektivitetsvinster tack vare snabbare utveckling och exakta resultat.

- MCP:s universella protokoll stöder verktyg, data och uppmaningar i alla AI-modeller.

Varför MCP är viktigt för agenternas effektivitet

MCP förvandlar AI från isolerade språkprocessorer till kontextmedvetna agenter som levererar exakta insikter i realtid utan hallucinationer.

Protokollet åtgärdar en grundläggande begränsning i dagens AI-system: modellerna är utmärkta på att resonera, men har svårt att få tillgång till live-data.

Innan MCP krävdes tre separata integrationer för att ansluta en AI-assistent till företagets Slack, GitHub och kunddatabas, var och en med olika autentisering, felhantering och underhållskostnader.

Verkliga organisationer rapporterar dramatiska effektivitetsvinster. Blocks Goose-agent visar att tusentals anställda sparar 50–75 % av sin tid på vanliga uppgifter, och vissa processer har minskat från dagar till timmar.

Den viktigaste skillnaden är kontextuell noggrannhet. När AI-agenter får tillgång till live-data via standardiserade MCP-servrar ger de specifika svar istället för generiska förslag, vilket minskar den fram- och återgång som vanligtvis saktar ner samarbetsflöden.

Fördelar och prestandaförbättringar som MCP möjliggör

MCP levererar mätbara förbättringar inom tre kritiska områden som direkt påverkar produktiviteten och noggrannheten:

1. Förbättrad noggrannhet

Genom att förse modeller med realtidskontext minskar MCP hallucinationer och eliminerar gissningar som leder till generiska svar. När en AI-agent kan söka i din faktiska kunddatabas istället för att förlita sig på träningsdata, levererar den specifika insikter istället för allmänna rekommendationer.

2. Utvecklingshastighet

Monte Carlo Data rapporterar att implementeringen av MCP minskar integrations- och underhållsarbetet samtidigt som det påskyndar distributionscyklerna. Istället för att bygga anpassade kopplingar för varje AI-leverantör skapar teamen en MCP-server som fungerar universellt.

3. Operativ effektivitet

Blocks incidenthantering visar denna effekt. Ingenjörer kan nu söka efter datamängder, spåra härkomst, hämta incidentdata och kontakta tjänsteägare genom frågor i naturligt språk, vilket minskar lösningstiden från timmar till minuter.

Den sammansatta effekten förändrar både utvecklingshastigheten och slutanvändarupplevelsen, vilket skapar en grund för mer sofistikerade AI-arbetsflöden.

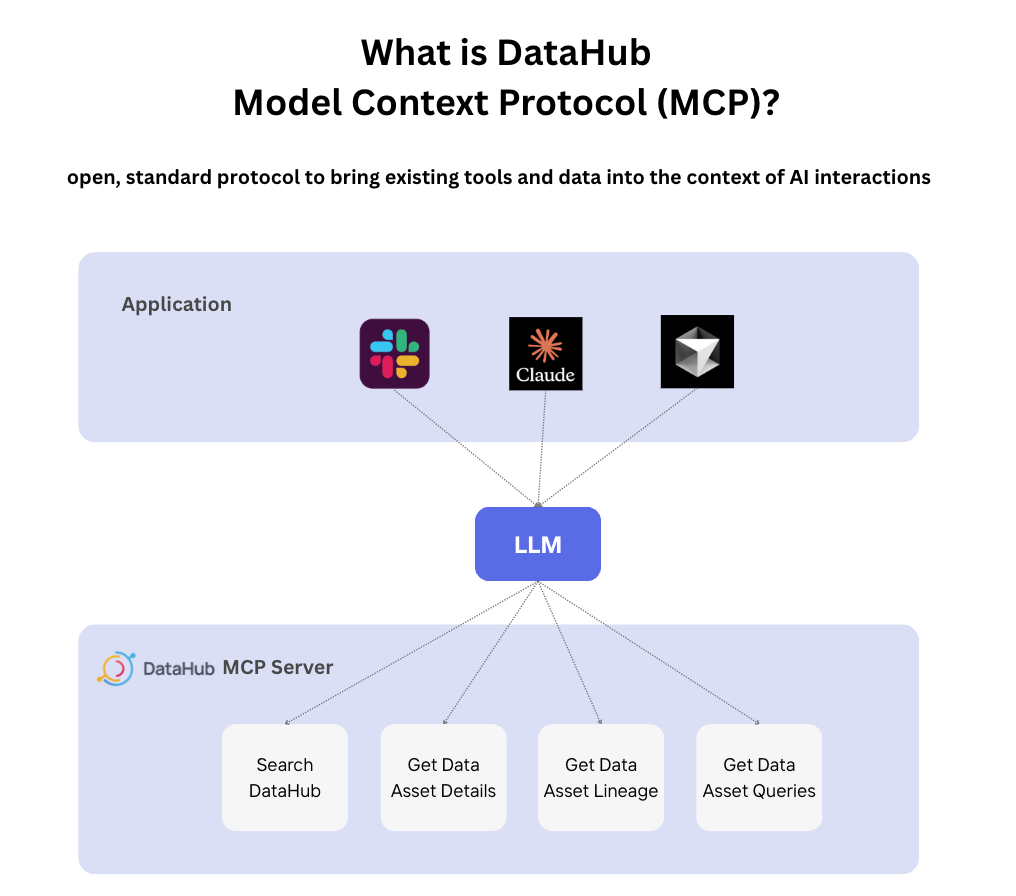

MCP:s allmänna arkitektur

MCP fungerar enligt en enkel värd-klient-servermodell där AI-applikationer (värdar) ansluter till MCP-servrar via ett standardiserat klientgränssnitt. Denna arkitektur möjliggör plug-and-play-funktionalitet som eliminerar leverantörsberoende.

Protokollet definierar tre kärnfunktioner:

- Verktyg: Exekverbara funktioner som att skicka e-post, skriva filer eller utlösa API-anrop.

- Resurser: Datakällor inklusive filer, databaser och live-feeds

- Prompts: Fördefinierade instruktioner som styr modellens beteende för specifika uppgifter.

- Transport: Kommunikationsmetoder inklusive STDIO för lokala servrar och HTTP för fjärråtkomst.

DataHubs MCP-server illustrerar denna arkitektur i praktiken genom att samla metadata från över 50 plattformar och tillhandahålla livekontext för AI-agenter.

Servern exponerar entitetssökning, härstamningsgenomgång och frågeassociation som standardiserade verktyg, vilket gör det möjligt för alla kompatibla AI-modeller att upptäcka och interagera med arbetsflöden för datastyrning.

Effektiva användningsfall för MCP och deras inverkan

MCP:s mångsidighet spänner över branscher och tekniska stackar, vilket bevisar dess värde utöver enkla produktivitetsintegrationer:

| Domän | Applikation | Effektmått |

|---|---|---|

| Mjukvaruutveckling | Cursor + GitHub-integration | 40 % minskning av tiden för PR-granskning |

| Datastyrning | DataHub-metadatatillgång | Från timmar till minuter för härkomstfrågor |

| Tillverkning | Tulip kvalitetshantering | Automatiserad analys av defekttrender |

| API-hantering | Apollo GraphQL-exponering | Enhetlig AI-åtkomst till mikrotjänster |

| Produktivitet | Google Drive, Slack-anslutningar | Sömlös plattformsoberoende automatisering |

Användningsfall inom tillverkningsindustrin lyfter särskilt fram MCP:s potential bortom mjukvara.

Tulips implementering kopplar AI-agenter till maskinstatus, felrapporter och produktionsscheman, vilket möjliggör naturliga språksökningar som "sammanfatta kvalitetsproblem över alla linjer denna vecka" som automatiskt sammanställer data från flera system.

Framtidsutsikter för MCP:er

Under de kommande 2–5 åren kommer MCP att utvecklas från en ny standard till ett grundläggande lager för företags-AI:

| Nuvarande läge | Framtida inriktning |

|---|---|

| Lokala servrar, skrivskyddade verktyg | Fjärrmarknadsplatser, skrivfunktioner |

| Manuell serverhantering | Dynamisk allokering, containerisering |

| Grundläggande autentisering | Finkornig auktorisering, förtroenderamverk |

| Enkel verktygsanropning | Multiagentkoordinering, automatisering av arbetsflöden |

OpenAI:s införande i mars 2025 signalerar en bredare branschutveckling. Analytiker förväntar sig att stora leverantörer kommer att enas om MCP som standardprotokoll för agentplattformar, med förbättrade säkerhetsverktyg och regelverk för att hantera aktuella sårbarheter.

DataHubs färdplan pekar mot AI-optimerade SDK:er med Pydantic-typiska ingångar och strömmande transport, medan forskningen fortsätter om dynamisk kontextstyrning för att hantera större verktygskataloger utan att modellens prestanda försämras.

Vanliga frågor

MCP bygger på funktionanropskoncept, men standardiserar verktygsupptäckt, metadatautbyte och transportsemantik mellan leverantörer. Det liknar mer Language Server Protocol för AI-agenter än en enskild leverantörs API.

De flesta utvecklare kan konfigurera grundläggande MCP-servrar med hjälp av befintliga mallar från Replit eller DataHub på bara några timmar. Protokollet använder välbekanta JSON-RPC-mönster, och det finns omfattande SDK:er för Python, TypeScript, Java och Rust.

Börja med OAuth 2. 1 för auktorisering, implementera användarbekräftelse för destruktiva operationer och validera alla verktygsbeskrivningar för dolda instruktioner. Överväg gateway-lösningar som centraliserar autentisering och validering av nyttolast.

Anthropics Claude Desktop, OpenAI:s ChatGPT och API-klienter samt olika open source-implementeringar stöder MCP. Standarden är utformad för universell kompatibilitet mellan kompatibla leverantörer.

![What Is MCP? Model Context Protocol Explained [In Simple Terms]](https://clickup.com/blog/wp-content/uploads/2025/06/MCP-Tools-Featured-Image.png)